引言:两大旗舰模型的编程赛道博弈

当 Google 祭出 Gemini 3.0 Pro 这款「协作型AI编程助手」,OpenAI 早已凭借 GPT-5.2 的「重载型智能」抢占开发者市场。前者以 1M Token 超大上下文与 Agent 自主规划为核心卖点,后者则靠 10 万亿级稀疏激活参数与 GitOps 深度集成站稳脚跟。

对开发者而言,选择哪款模型直接影响项目效率与开发质量——是优先追求「全流程自主落地」,还是侧重「复杂任务深度推理」?本文通过 6 大核心场景实测、3 组关键数据对比、1 套实操接入方案,全面拆解两者差异,帮你精准选型、高效上手。

一、核心能力PK:编程场景的关键差异我们聚焦开发者高频使用场景,从代码修复、多模态开发、大型项目适配三大维度,结合权威测试数据与实战案例,直观呈现两款模型的性能差距与能力侧重。

1.1 代码修复:稳定落地 vs 精准攻坚

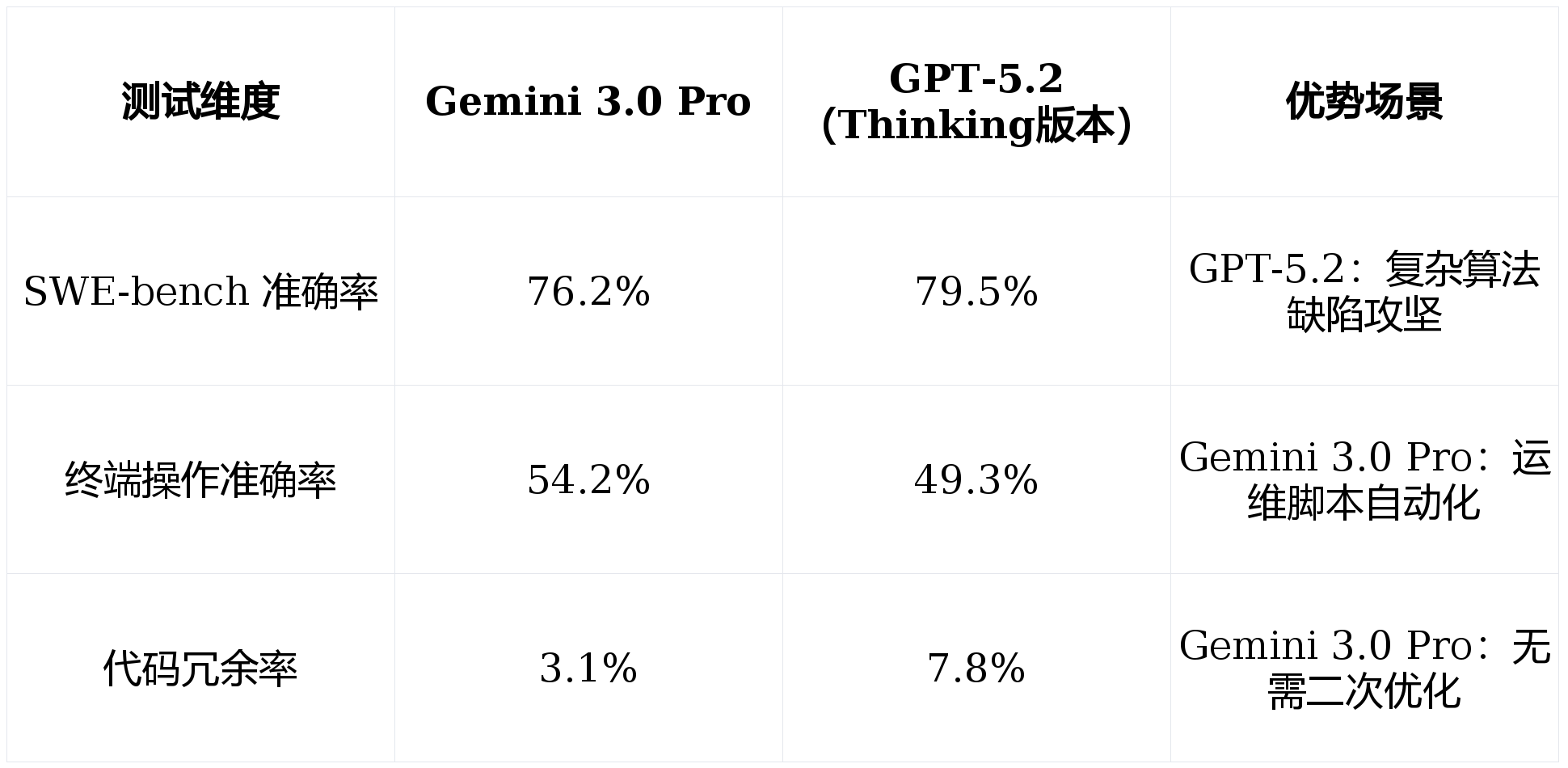

代码缺陷修复是AI编程工具的核心刚需,SWE-bench Verified 测试(500项GitHub真实缺陷)与终端操作测试(Terminal-Bench 2.0)的结果,直接反映模型的实战可靠性:

实战案例:电商平台订单模块Bug修复

针对「高并发下订单状态更新异常」的隐性Bug,Gemini 3.0 Pro 10秒内定位到数据库锁机制漏洞,生成的修复代码包含分布式锁实现与异常回滚逻辑,直接集成无报错;GPT-5.2 虽能识别漏洞根源,但修复代码存在冗余的锁释放逻辑,需手动精简才能适配生产环境。

1.2 多模态开发:视觉到代码的闭环对决

多模态已成为AI编程的核心竞争力,但两款模型的落地能力差异显著——Gemini 3.0 Pro 聚焦「视觉需求→代码落地」全闭环,GPT-5.2 则偏向「多模态知识融合」,编程场景针对性不同。

- Gemini 3.0 Pro(MMMU-Pro 81分):支持UI草图、流程图、网页截图直接生成可运行代码。上传移动端商城手绘原型,可自动输出 Flutter 响应式组件,集成状态管理与API接口适配,30分钟完成前端开发,无需额外调试。

- GPT-5.2(MMMU-Pro 78分):擅长多模态知识关联,如通过工程图纸生成技术文档、结合UI截图分析交互逻辑,但生成代码仅为基础结构(如HTML静态页面),框架适配与交互逻辑需手动开发,无法直接落地。

1.3 大型项目适配:上下文窗口 vs 推理深度

jrhz.info处理10万行+大型代码库时,上下文窗口大小与推理连贯性直接决定开发效率。Gemini 3.0 Pro 以1M Token超大窗口实现全量代码解读,GPT-5.2 则靠深度推理攻克局部复杂模块,两者形成互补:

Gemini 3.0 Pro(1M Token)

✅ 一次性加载整个项目代码与文档

✅ 留存长期迭代的上下文信息,无需重复补充需求

✅ 适配大型项目的模块间关联优化

❌ 复杂算法推理精度略低于GPT-5.2

GPT-5.2(400K Token)

✅ 复杂算法求解与跨领域知识融合能力突出

✅ 支持推理参数调整,适配不同精度需求

✅ 局部模块优化(如算法重构)效率更高

❌ 超大型代码库需分段解读,上下文易丢失

二、开发模式革新:自主规划 vs 指令驱动两款模型的核心差异,本质是开发协作模式的不同——Gemini 3.0 Pro 以 Agent-first 架构实现「自主规划全流程」,GPT-5.2 则保持「指令驱动+工具调用」的传统模式,效率差距在复杂项目中尤为明显。

2.1 全流程自主开发:从需求到交付的一键落地

在「企业级物流追踪系统」开发实战中,两款模型的协作效率差距显著:

- Gemini 3.0 Pro:输入需求后,自主拆解为「前端(Vue3+Vite)、后端(Spring Cloud)、数据库(PostgreSQL)、第三方物流接口对接」四大模块,自动完成代码生成、单元测试、性能优化,生成部署文档与Docker配置,全程仅需开发者确认2处细节,3小时完成从需求到可部署版本的落地。

- GPT-5.2:需开发者逐一下达「生成前端页面→编写后端接口→设计数据库表」等指令,遇到接口报错、数据异常等问题需人工介入排查,全程耗时8小时,且需手动整合各模块代码。

Vending-Bench 2全年模拟运营测试也印证了这一差距:Gemini 3.0 Pro 以5478.16美元💵净资产收益,远超 GPT-5.2 的3200美元💵,自主规划与全流程落地能力更胜一筹。

2.2 多代理协作:Gemini的独家优势

多代理协作是 Gemini 3.0 Pro 的核心亮点(GPT-5.2 无原生支持,需第三方插件),可自动联动「视觉设计、前后端开发、测试校验」等专业AI代理,形成闭环协作:

- 需求解析代理:拆解业务需求,输出技术方案与模块划分;

- 开发代理:分模块生成代码,确保编码规范统一;

- 测试代理:自动生成测试用例,执行自动化测试并修复Bug;

- 部署代理:配置部署环境,生成运维文档。

对中小型团队而言,这套协作体系相当于免费拥有一个轻量化智能开发团队,可大幅降低协作成本与管理难度。

2.3 技术栈适配:全语言覆盖 vs 主流聚焦

在跨语言与开源库适配方面,两者的侧重点不同,直接影响多技术栈项目开发效率:

- Gemini 3.0 Pro:支持 Python、Java、Rust、Elixir 等20+语言,小众语言支持精度达85%以上;内置开源库实时同步模块,可自动适配 React 18、Spring Boot 3 等最新版本特性,避免兼容性问题。

- GPT-5.2:主打 Python、JavaScript、Java 等主流语言,小众语言支持精度约60%;对开源库最新版本的适配存在1-2周延迟,生成代码需手动校验兼容性,偶有语法冗余问题。

生态适配与使用门槛,决定了模型的适用人群——Gemini 3.0 Pro 兼顾个人开发者与企业需求,GPT-5.2 则更适配具备 DevOps 基础的团队,两者各有侧重。

3.1 工具链集成:全流程自动化 vs GitOps 聚焦

- Gemini 3.0 Pro:拥有专属 Antigravity 编程平台,支持多模型切换、漏洞自动检测,可直接接入 CI/CD 流水线;VS Code 插件支持实时代码补全、函数重构、文档生成,『Chrome』 插件实现「浏览-咨询-编码」连贯体验,无需切换平台。

- GPT-5.2:聚焦 GitOps 与 CI/CD 流水线集成,可自动生成流水线配置、实现故障自修复;无专属开发平台,VS Code 插件仅支持基础代码补全,浏览器场景需通过第三方工具对接,操作链路较长。

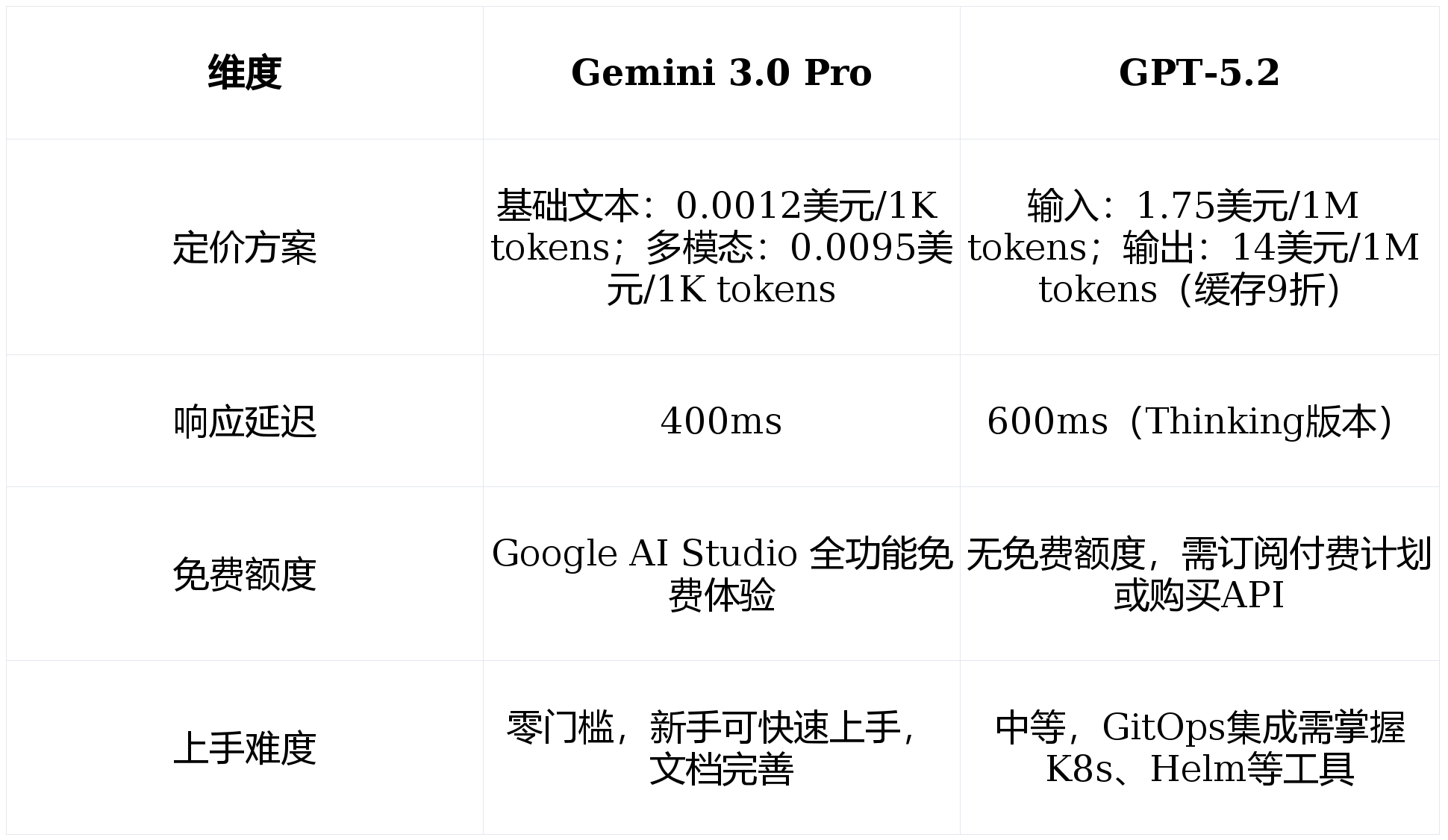

3.2 定价与上手门槛:亲民 vs 专业

3.3 安全合规:敏感领域适配能力

对金融、医疗等敏感领域,安全与合规性至关重要:

- 幻觉率:Gemini 3.0 Pro 仅6.3%,低于 GPT-5.2 的9%,可有效避免错误代码导致的合规风险;

- 数据安全:Gemini 3.0 Pro 采用「数据隔离」架构,用户数据仅用于当前任务,无泄露风险;GPT-5.2 需额外配置数据加密策略,才能满足敏感领域合规要求。

相较于 GPT-5.2 复杂的配置流程,Gemini 3.0 Pro 提供了更简洁的API接入方式,3步即可上手,支持代码调用与开源工具无代码适配。

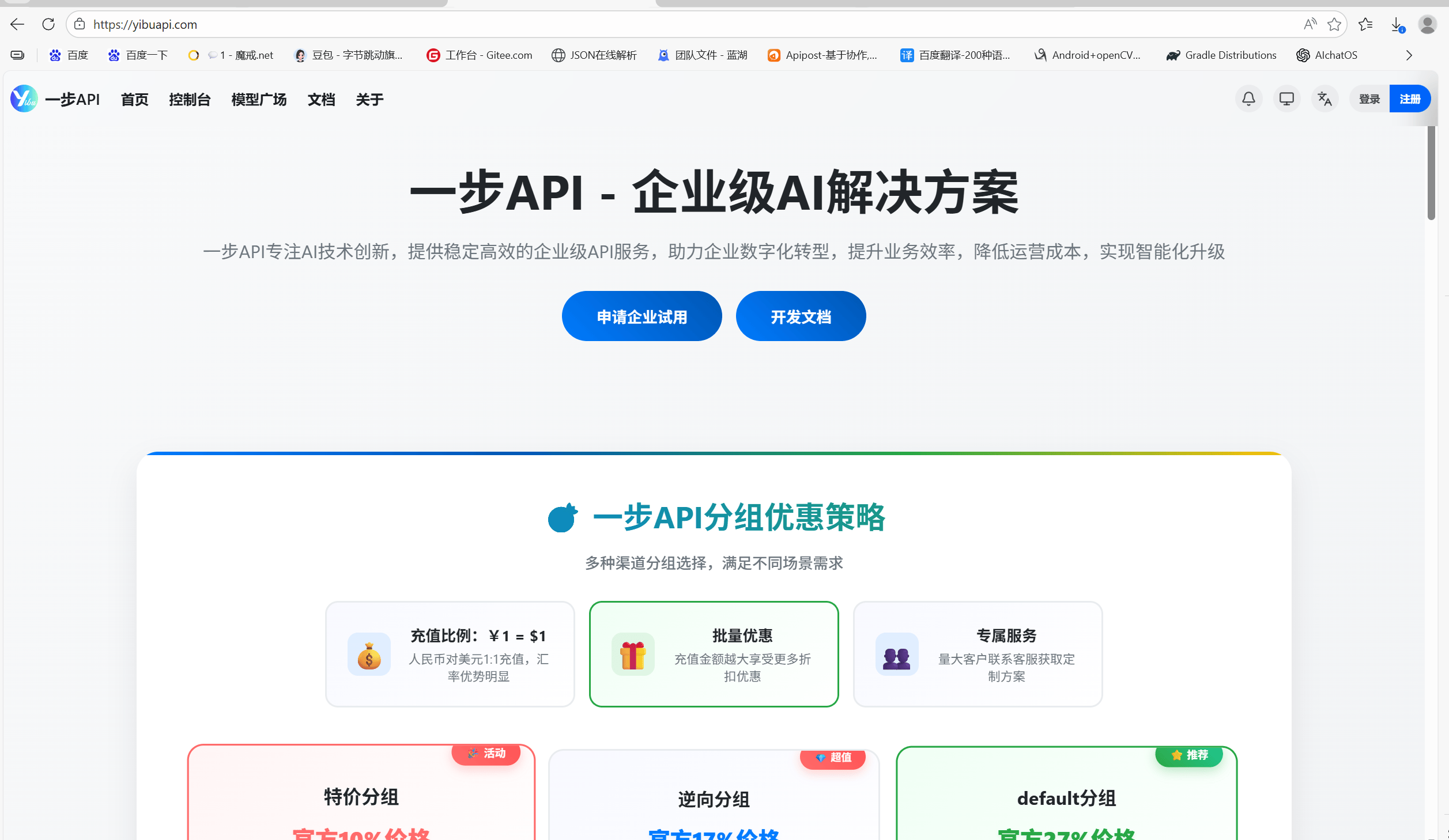

4.1 步骤1:获取API密钥

- 登录一步API中转服务平台(https://yibuapi.com/),完成注册与实名认证;

- 进入后台「API密钥」模块,点击「创建密钥」,自定义名称并勾选编程相关权限(最小权限原则);

- 复制密钥,保存至环境变量(避免代码硬编码),防止泄露。

4.2 步骤2:Python环境配置与代码调用

环境准备

安装官方依赖库(推荐0.7.0及以上版本):

pip install google-generativeai

完整调用代码(含多模态示例)

import google.generativeai as genai

import os

# 配置API密钥(从环境变量读取,更安全)

genai.configure(

base_url="https://yibuapi.com/v1",

api_key=os.getenv("GEMINI_API_KEY")

)

# 模型参数配置(按需调整)

model_config = {

"temperature": 0.6, # 创造性:0-1,越低越精准

"max_output_tokens": 4096, # 输出长度上限

"top_p": 0.9, # 输出多样性

}

# 初始化模型(设置角色与输出规范)

model = genai.GenerativeModel(

model_name="gemini-3-pro-latest",

generation_config=model_config,

system_instruction="作为全栈开发『工程师』,生成代码需附带详细注释,遵循行业规范,适配生产环境,支持多模态需求落地。"

)

try:

# 示例1:文本需求(生成Redis缓存工具类)

text_req = "用Python写一个Redis缓存工具类,包含增删改查、过期时间设置,支持连接池配置,附带使用示例"

text_resp = model.generate_content(text_req)

print("=== 文本需求响应 ===")

print(text_resp.text)

# 示例2:多模态需求(根据截图生成Vue3页面)

# image = genai.upload_file(path="vue_dashboard.png") # 本地截图路径

# multi_req = ["生成与截图一致的Vue3+Element Plus页面,支持响应式,集成表格与图表", image]

# multi_resp = model.generate_content(multi_req)

# print("\n=== 多模态需求响应 ===")

# print(multi_resp.text)

except Exception as e:

print(f"调用失败:{str(e)}")

print("排查要点:1. 密钥是否正确 2. 接口地址是否可访问 3. 依赖库版本是否达标 4. 额度是否充足")

4.3 步骤3:开源工具无代码接入(以NextChat为例)

- 打开NextChat,进入「设置」→「模型配置」→「添加模型」;

- 填写信息:模型名称「Gemini 3.0 Pro」,Base URL「https://yibuapi.com/v1」;

- 粘贴API密钥,模型标识填写「gemini-3-pro-latest」,类型选「Gemini」;

- 保存配置后,即可直接调用,支持文本与多模态输入。

通过多维度实测,两款模型的适用场景已清晰呈现,开发者可根据自身需求精准选型:

5.1 选型建议

优先选 Gemini 3.0 Pro 的场景:大型项目开发、多模态落地需求、中小型团队协作、敏感领域开发、新手入门(零门槛)。

优先选 GPT-5.2 的场景:复杂算法开发、GitOps 自动化、多模态知识融合任务、具备DevOps基础的团队。

5.2 未来展望

Gemini 3.0 Pro 以「自主协作+全流程落地」重构了AI编程模式,GPT-5.2 则在「深度推理+专业化适配」上持续发力。随着两者生态的完善,AI编程将逐步实现「需求输入→成果输出」的全自动化,开发者可聚焦核心业务逻辑,大幅提升研发效率。

对追求高效落地与团队协作的开发者而言,Gemini 3.0 Pro 无疑是当前更优选择,其零门槛接入与工业级可靠性,可快速适配各类开发场景,助力研发效率质的飞跃。

文末福利

关注我,回复「Gemini选型」即可获取《Gemini 3.0 Pro 企业级部署指南》,包含高并发场景优化、多模型协同方案、敏感数据脱敏技巧等实战内容,帮你快速落地AI编程工具!