『英伟达』创始人兼首席执行官黄仁勋在今年的CES 2026上,正式了最新的Rubin平台,确认“已经全面投产”,开启新的AI之旅。

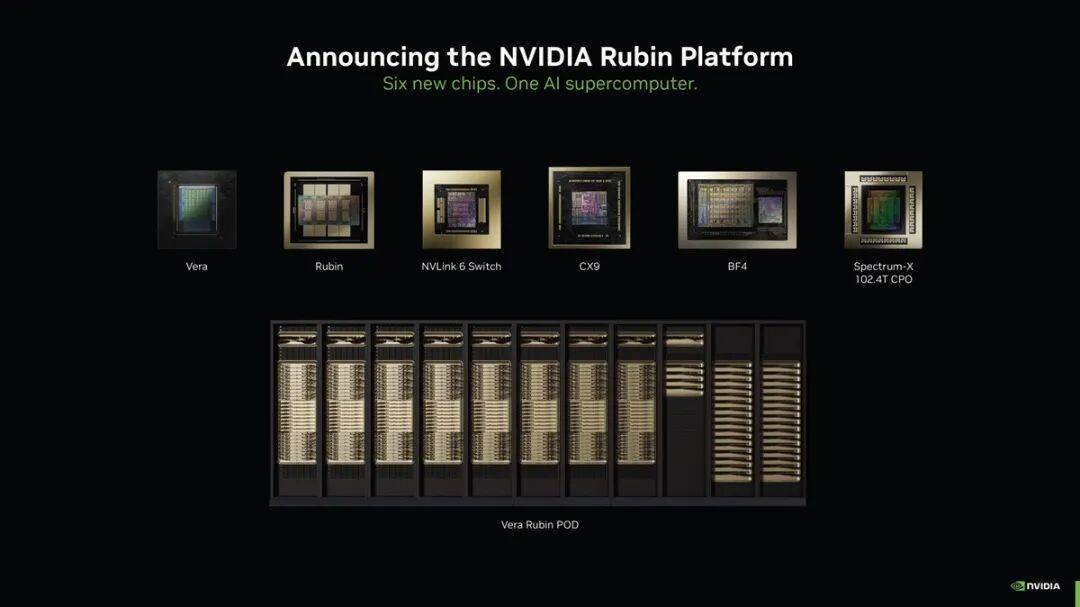

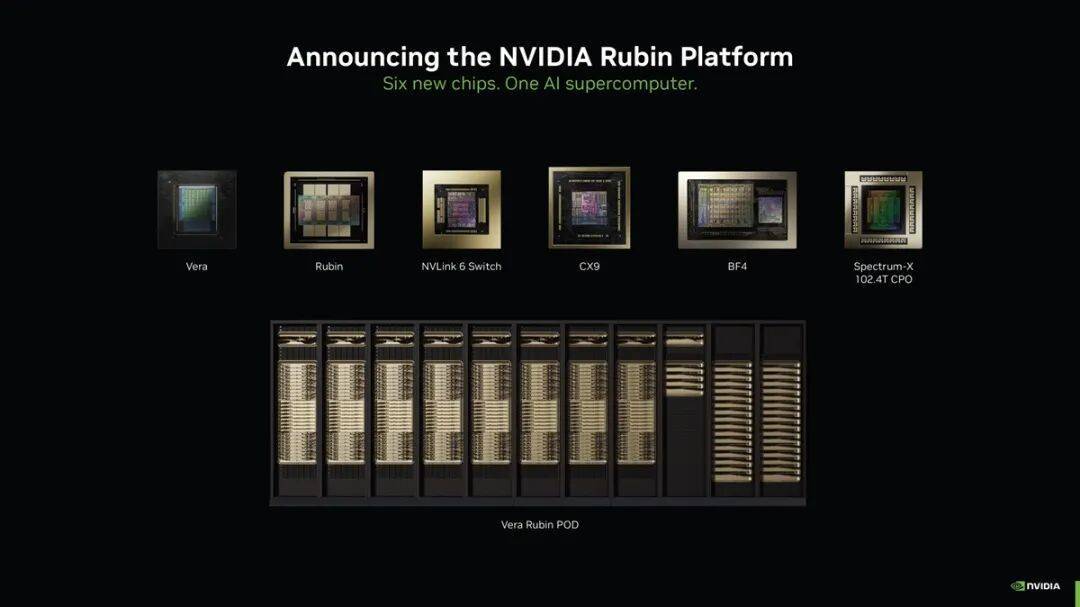

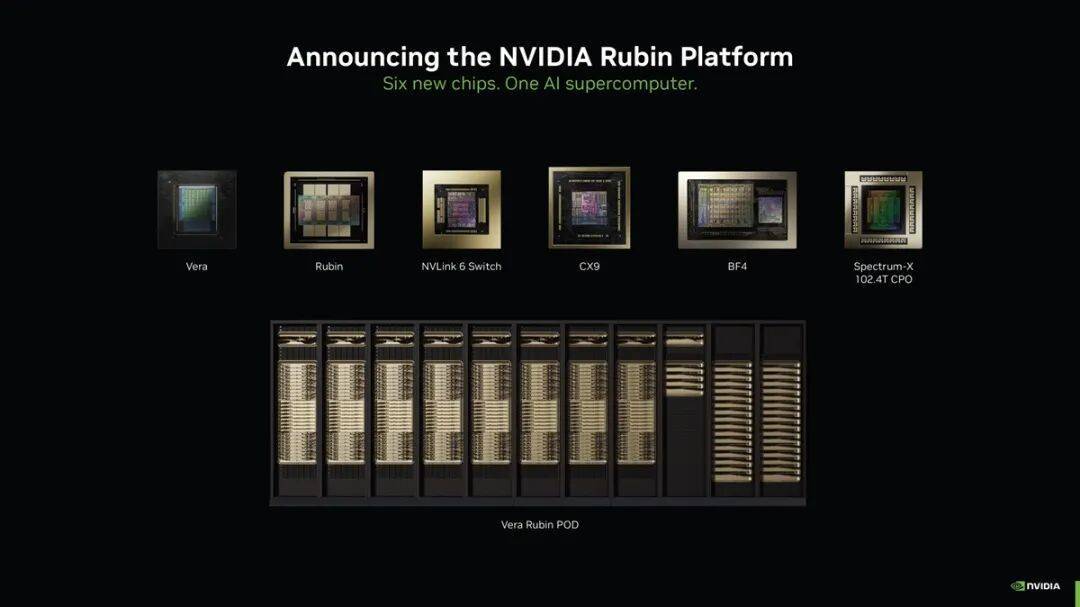

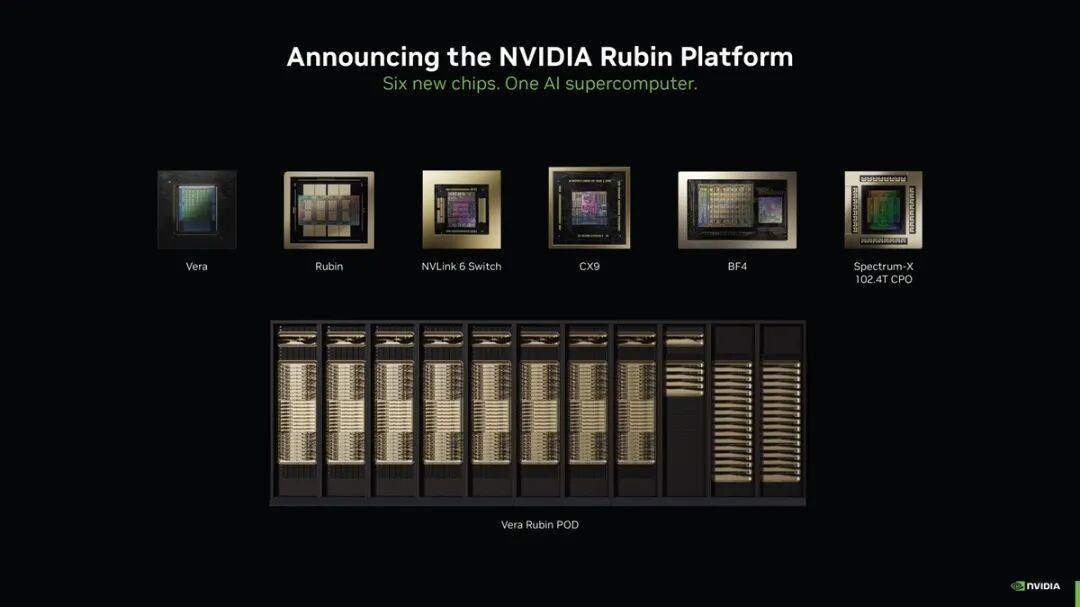

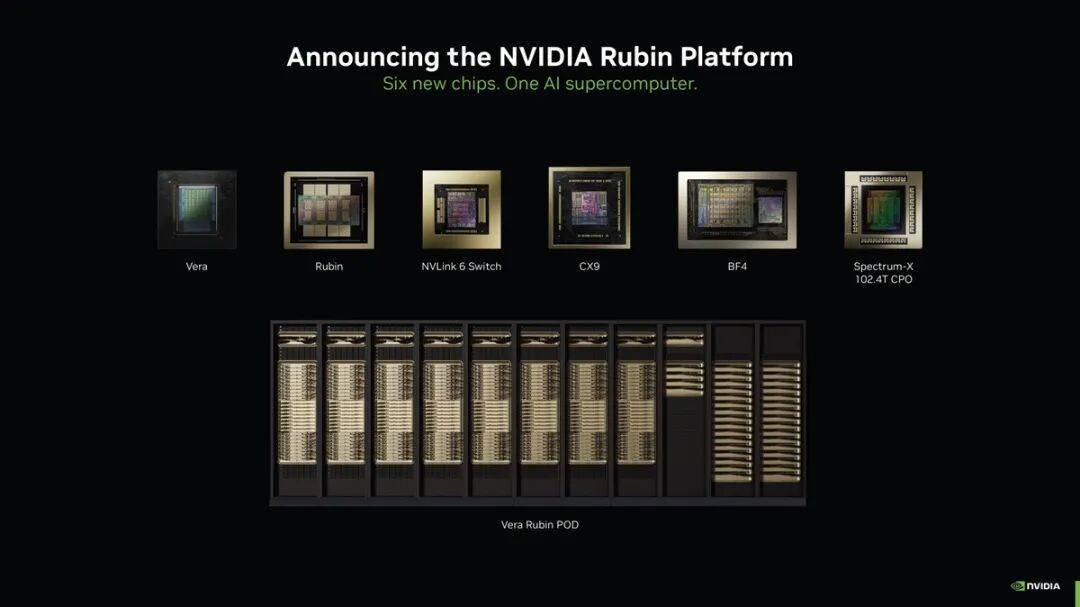

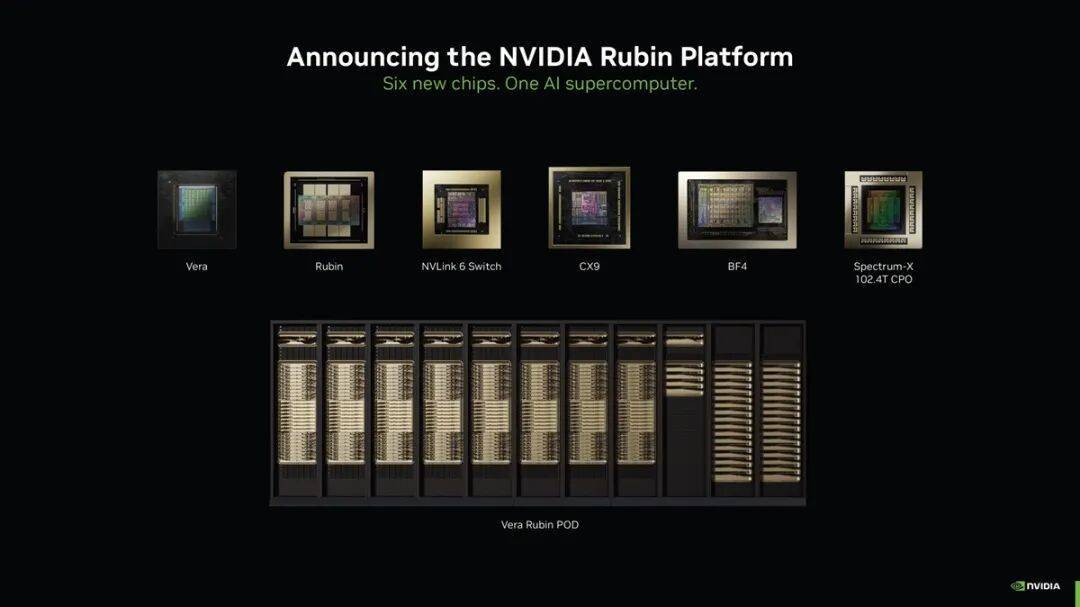

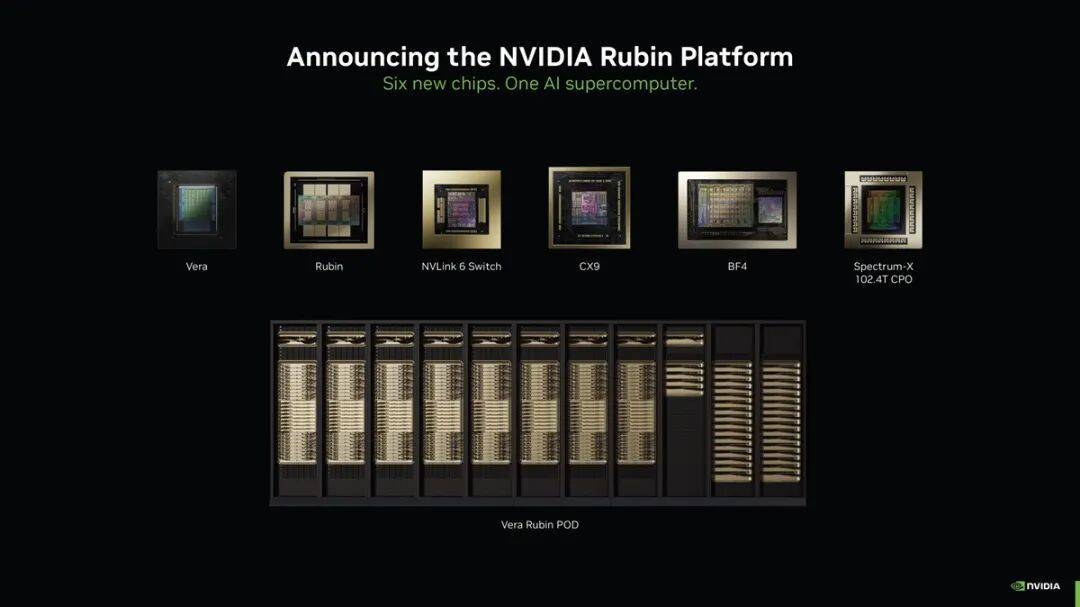

新平台由六款全新『芯片』组成,包括Vera CPU、Rubin GPU、NVLink 6交换机、ConnectX-9 SuperNIC、BlueField-4 DPU和Spectrum-6以太网络交换机,通过极致的协同设计,打造成一台性能惊人的AI超级计算机,大幅缩短AI训练时间并降低推理Token生成成本。

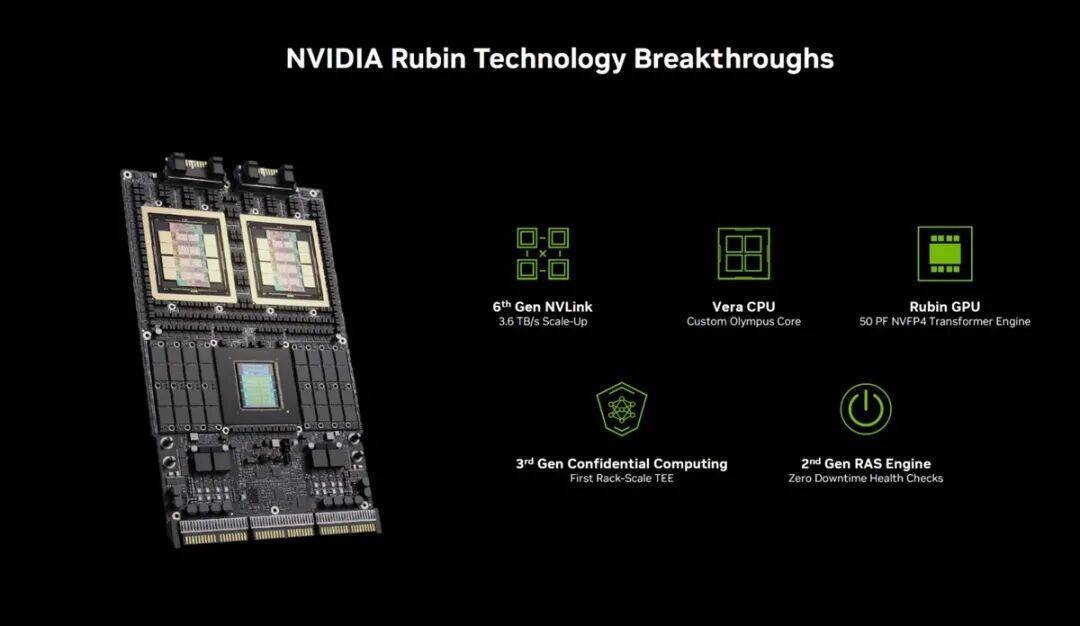

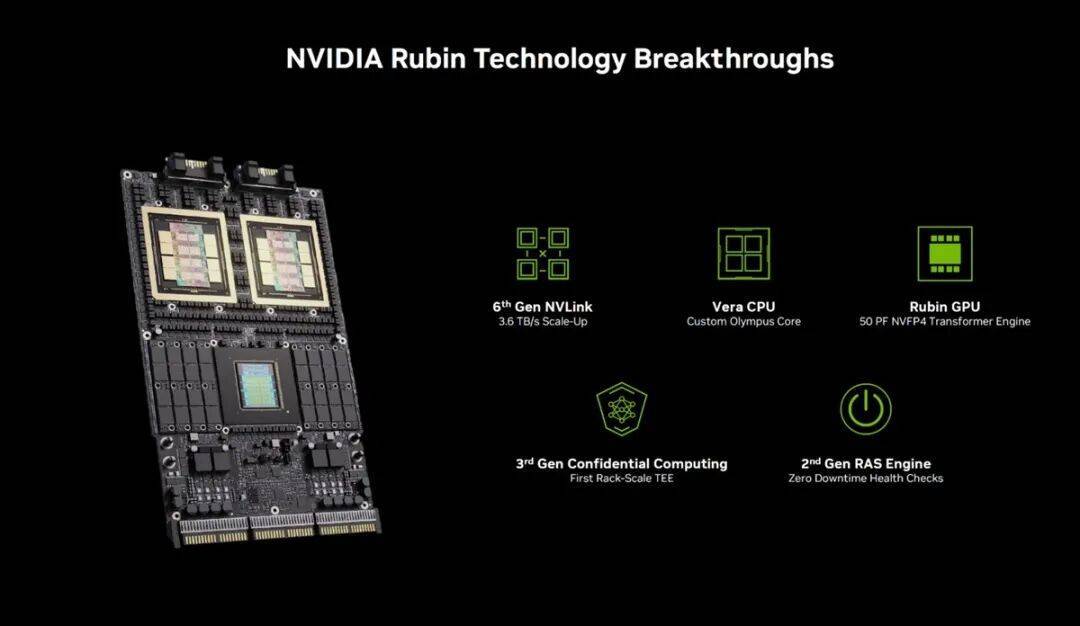

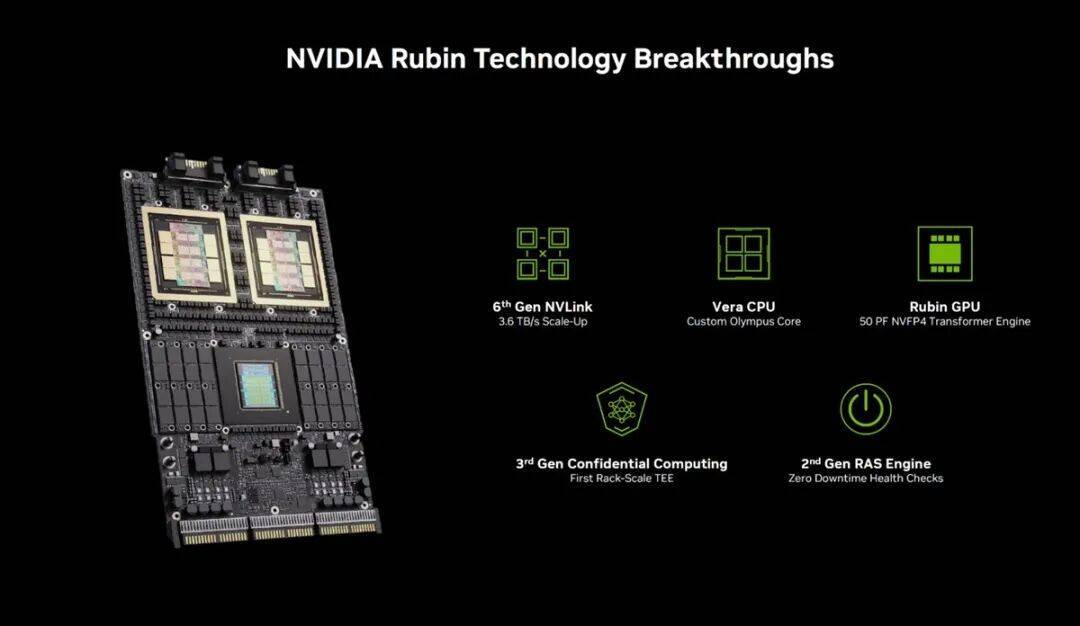

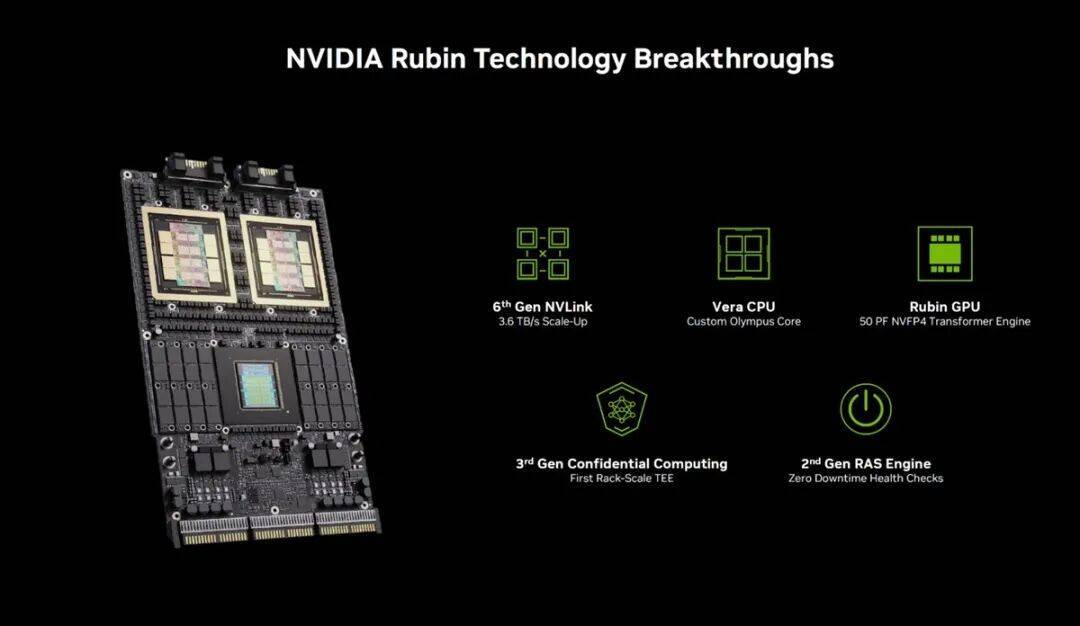

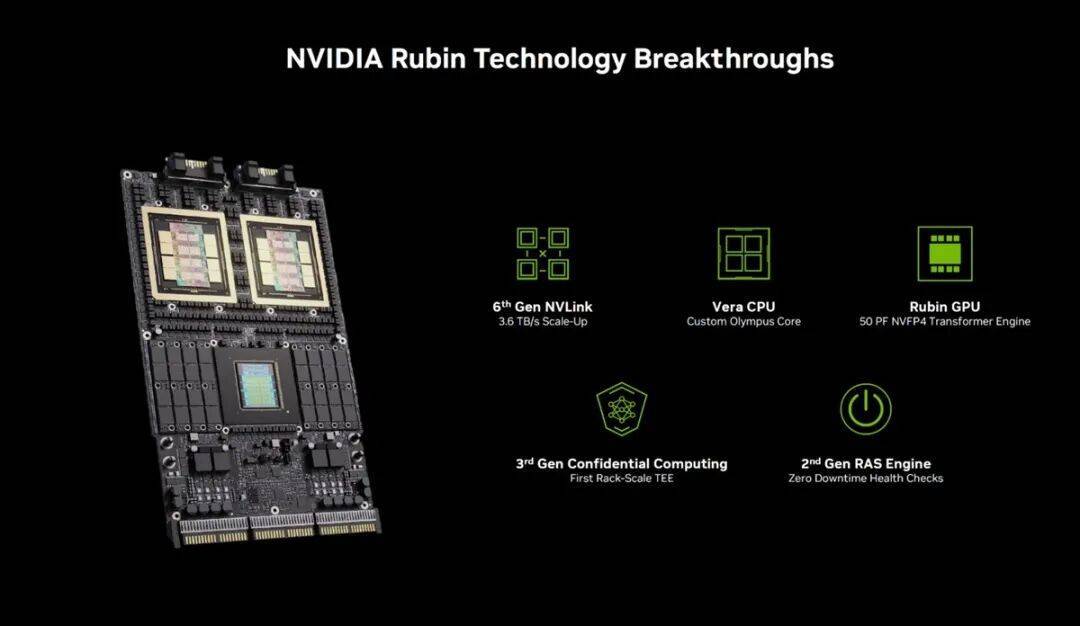

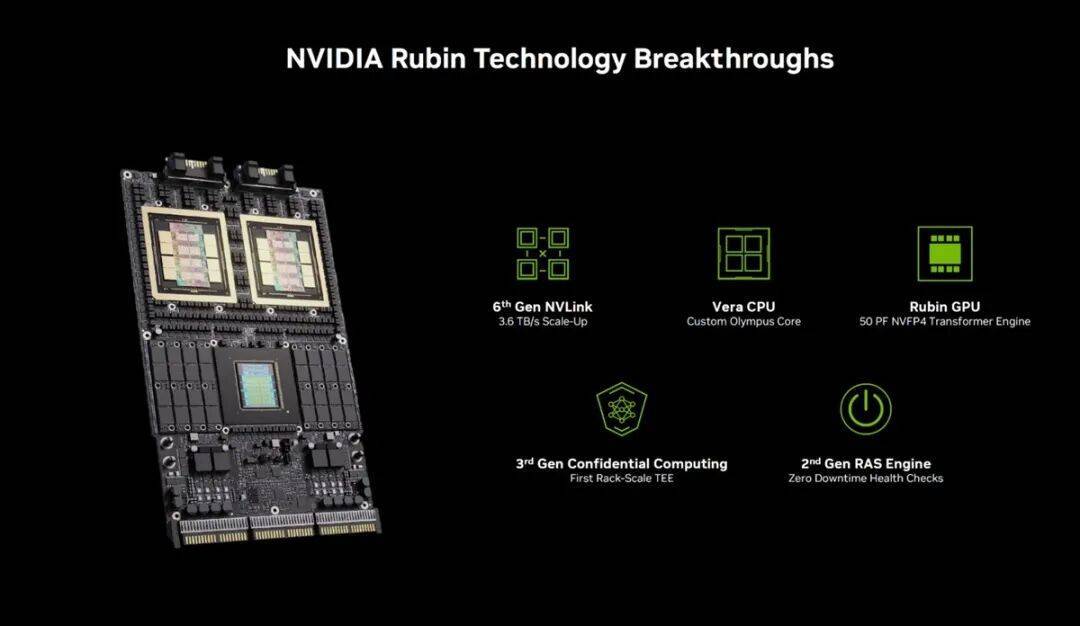

Rubin平台以Vera Florence Cooper Rubin命名,这是一位具有开创精神的美国天文学家,她的发现改变了人类对宇宙的理解。新平台包括NVIDIA Vera Rubin NVL72机架级扩展解决方案和NVIDIA HGX Rubin NVL8系统,引入了五项创新技术,分别为Vera CPU、新一代NVIDIA NVLink互连技术、第三代Transformer引擎、第三代NVIDIA机密计算、以及第二代RAS引擎。

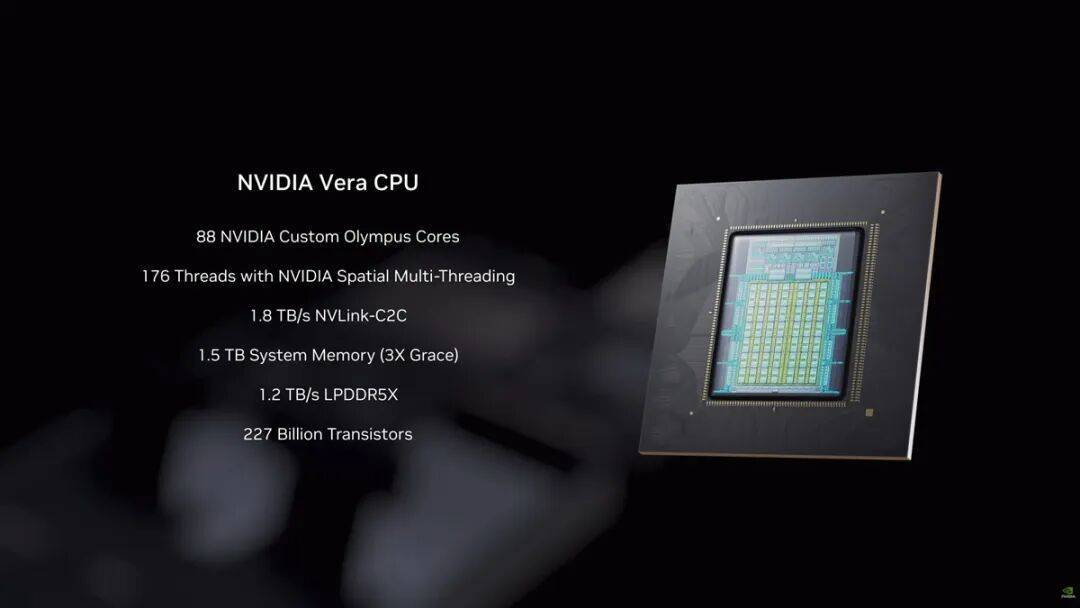

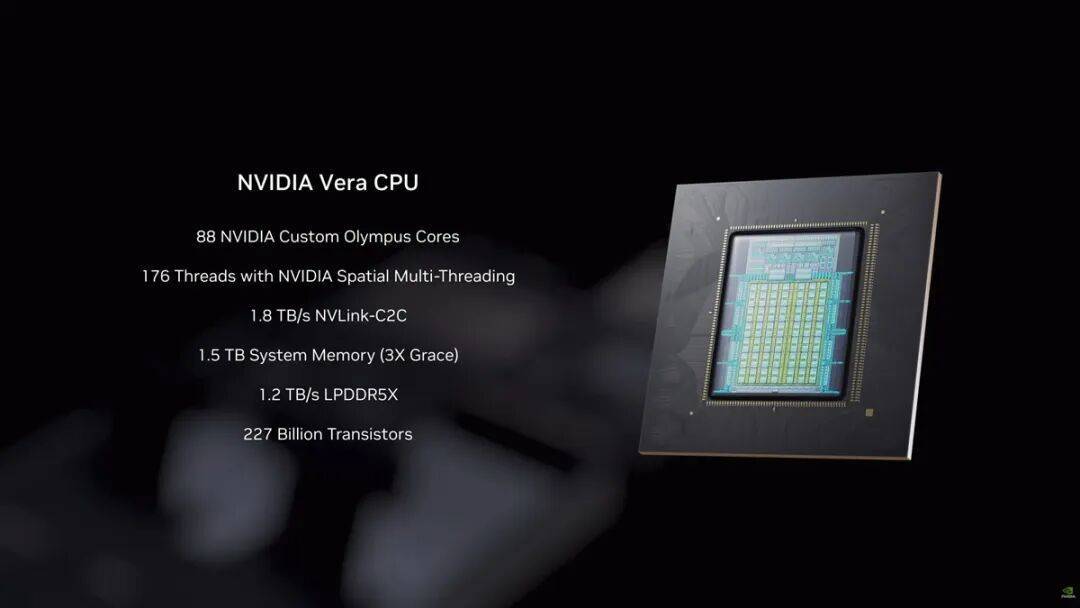

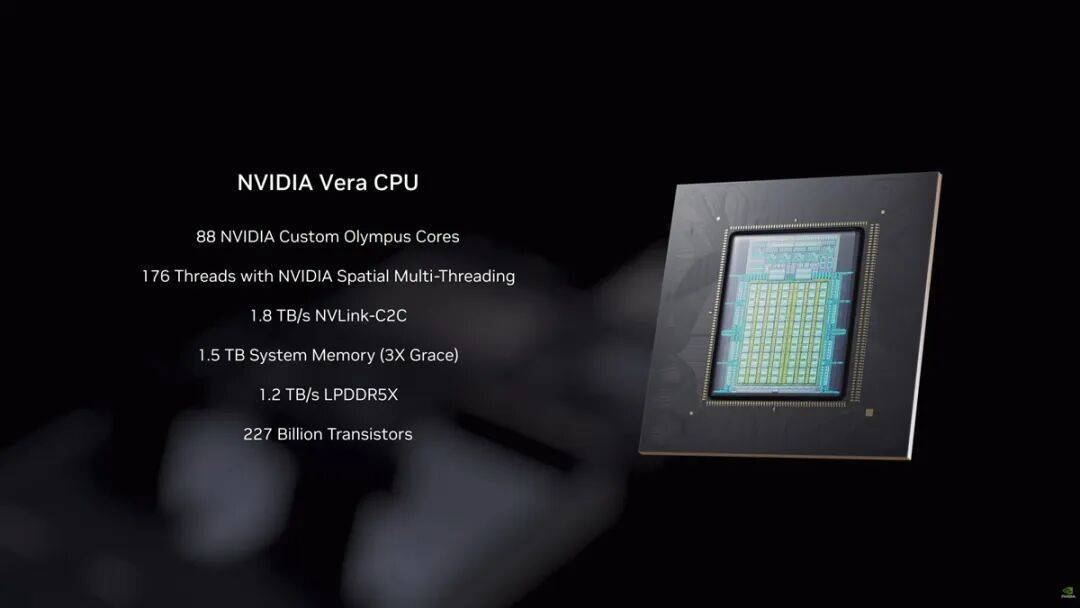

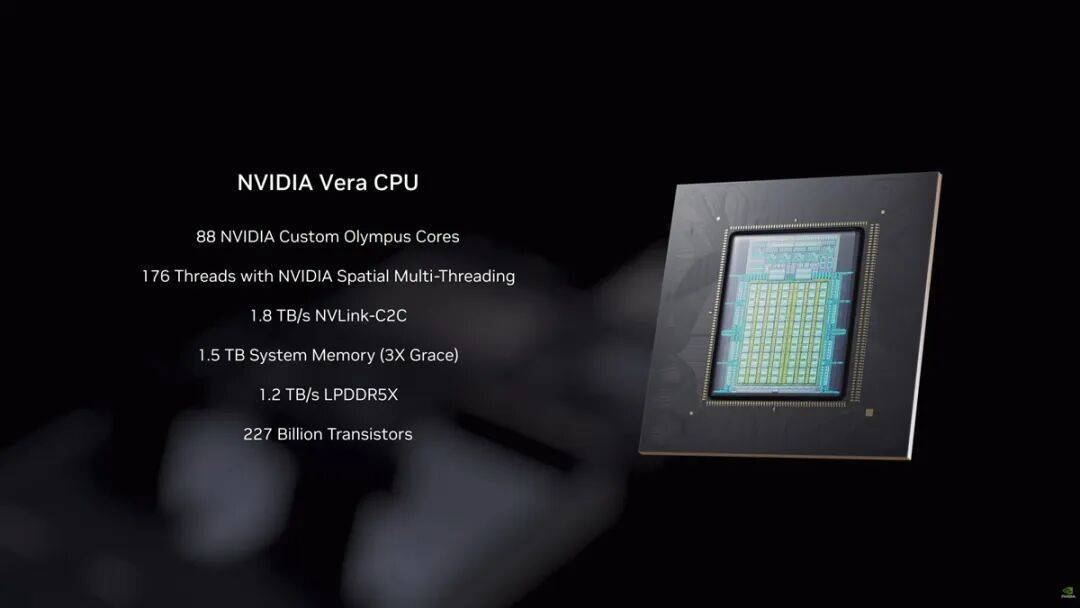

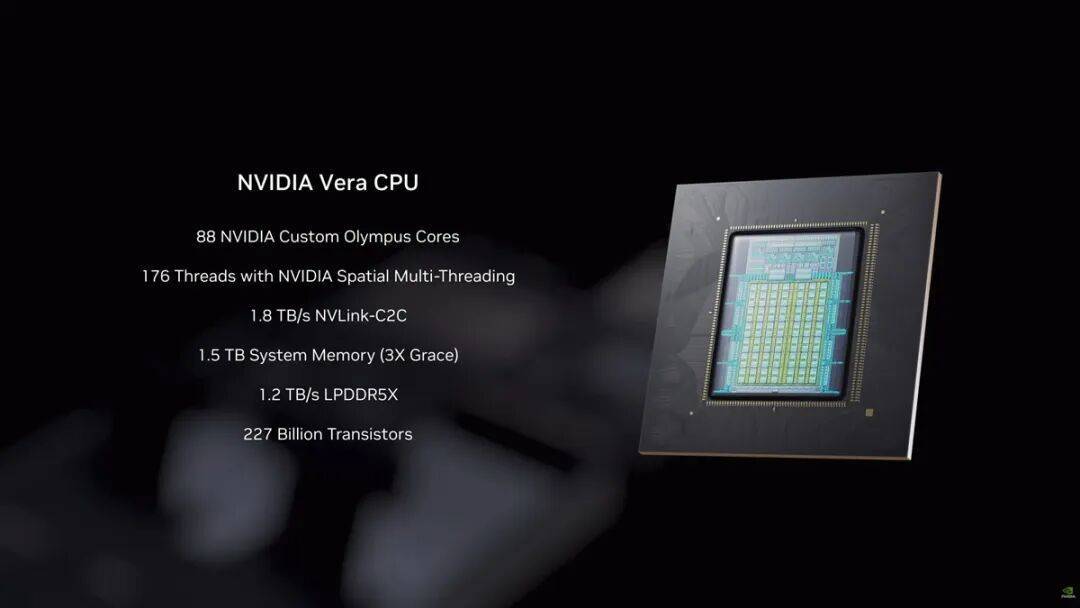

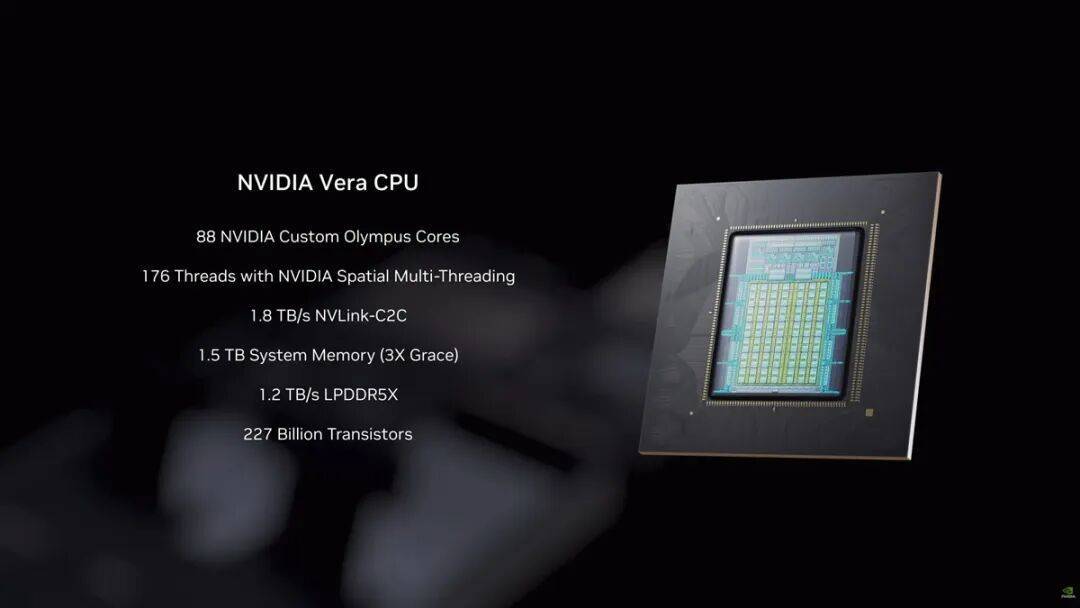

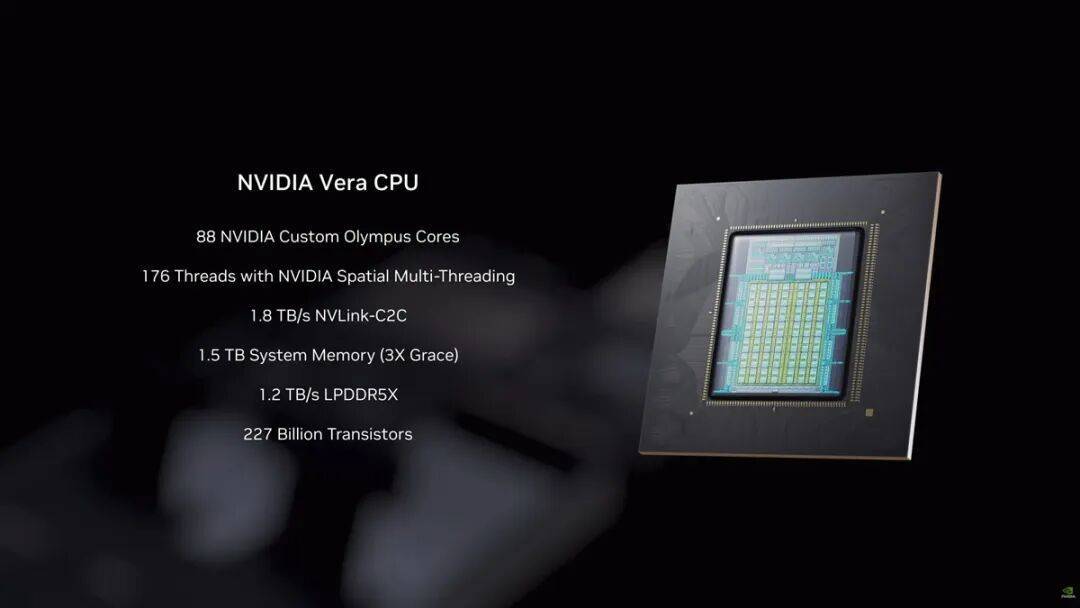

Vera CPU拥有88个定制的Olympus核心,完全兼容Armv9.2,采用了“空间多线程(spatial multi-threading)”技术,可支持176个线程,每个核心拥有2M的L2缓存,另外还有162MB的统一L3缓存;最大支持1.5TB SOCAMM LPDDR5X内存,提供了1.2 TB/s的内存带宽;支持超高速NVLink-C2C互连技术,对应带宽可达到1.8 TB/s;支持PCIe 6.0和CXL 3.1标准。

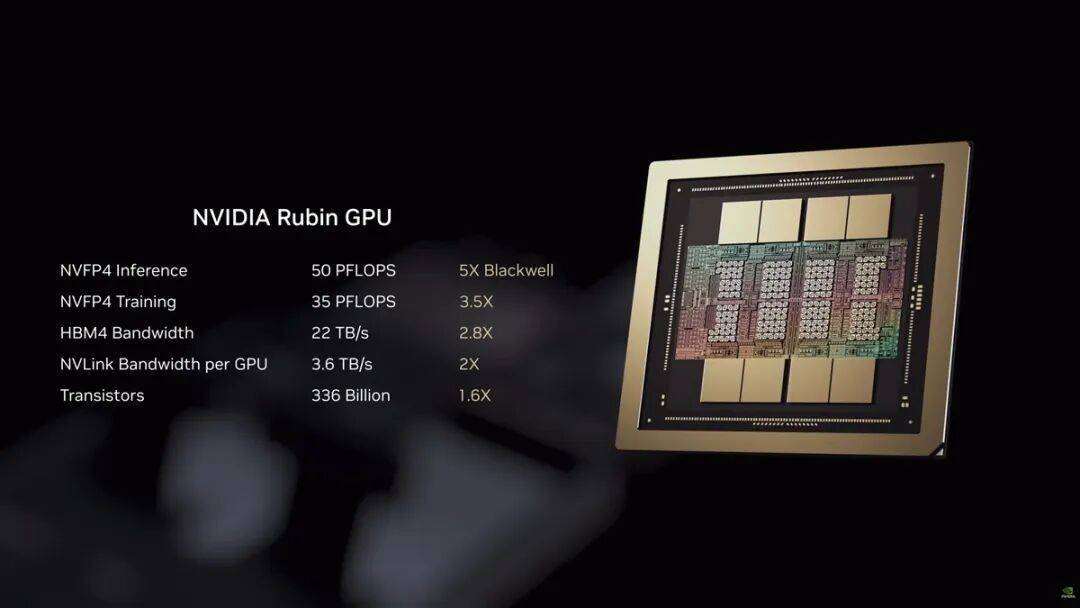

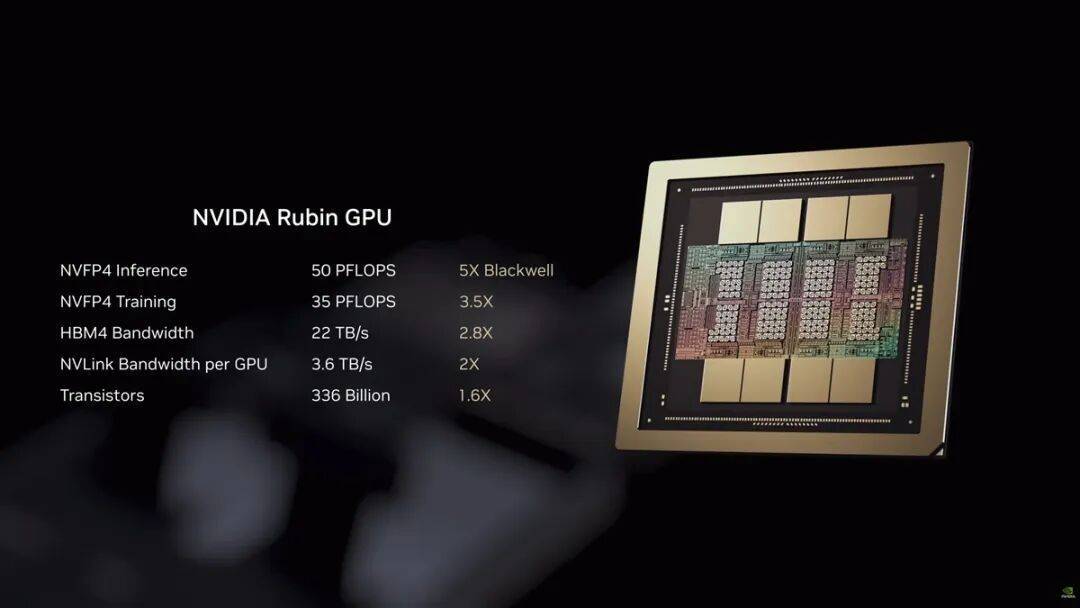

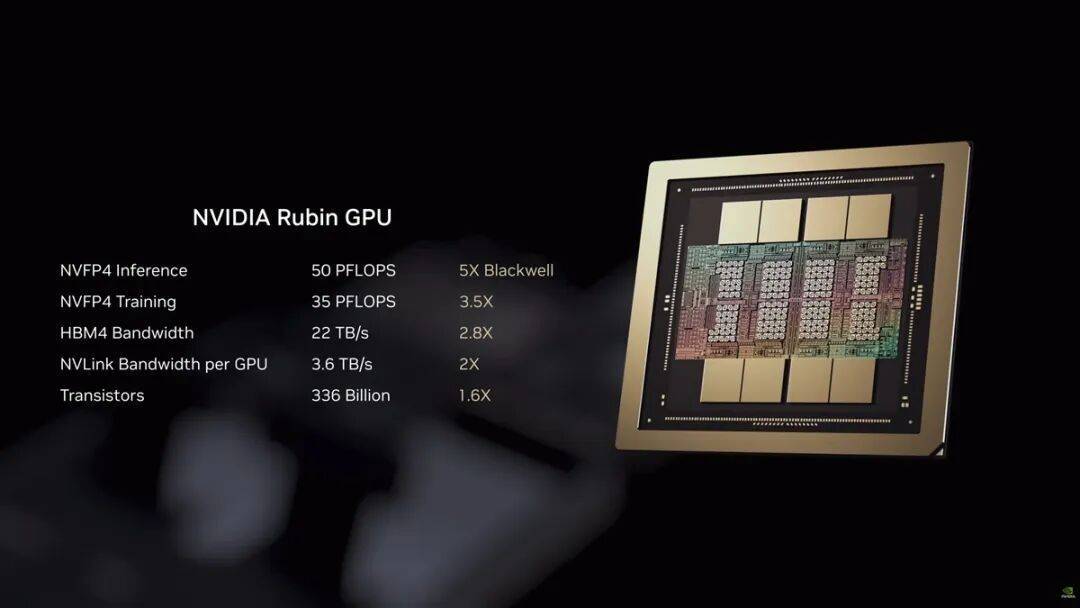

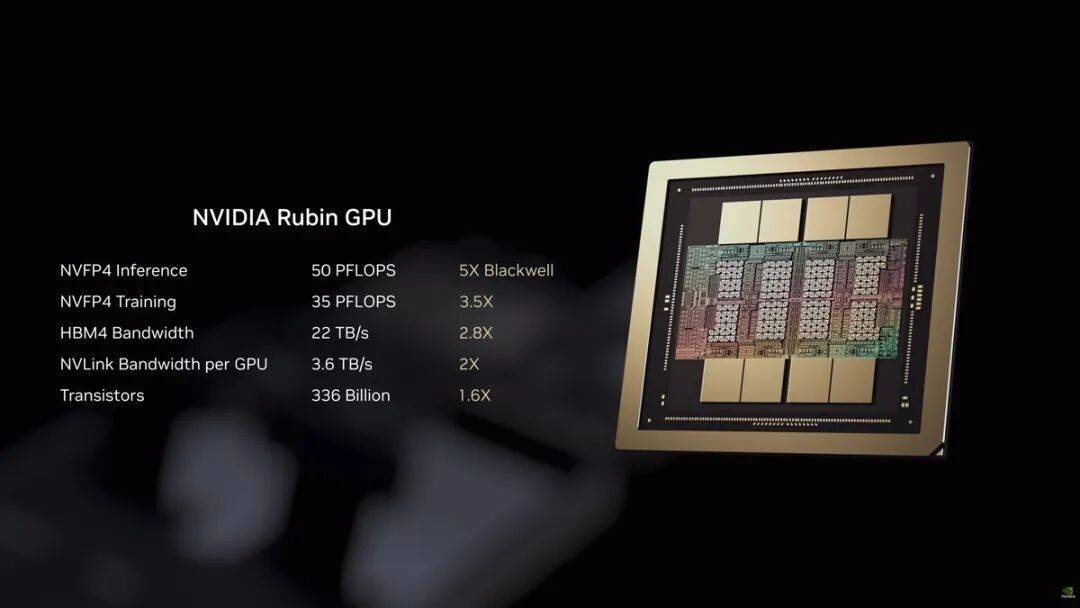

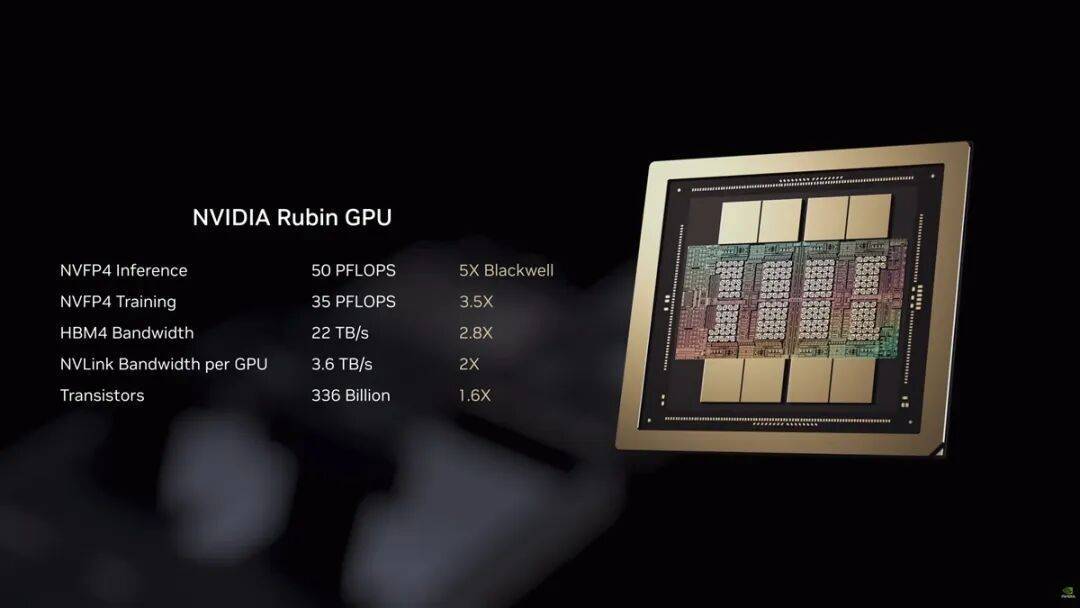

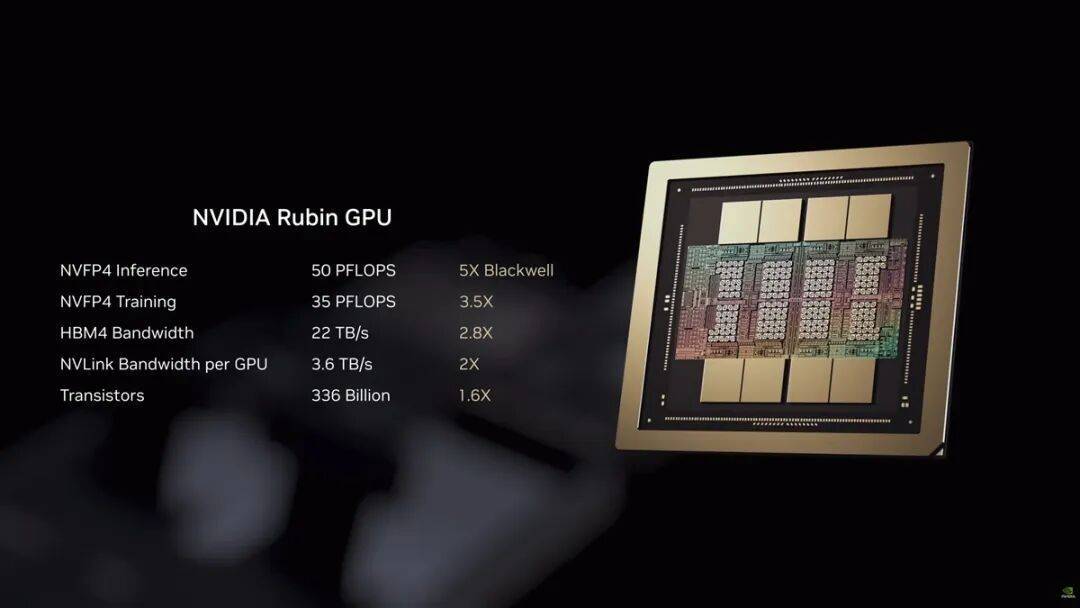

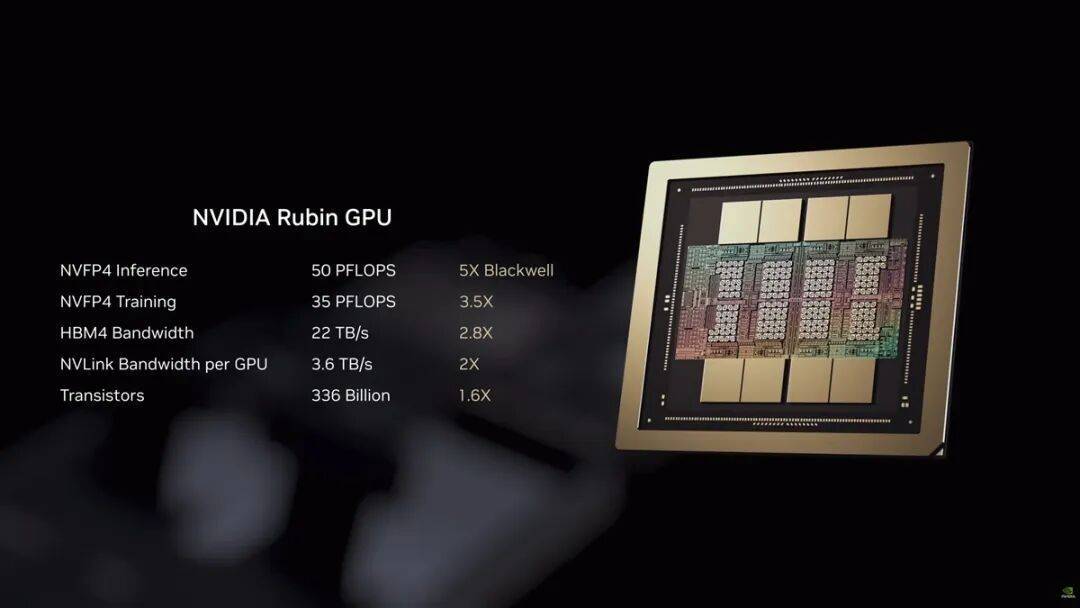

Rubin GPU由两颗Die组成,集成了224个SM,第六代Tensor Core,HBM4提供了22 TB/s的带宽,每颗GPU拥有3.6 TB/s的NVLink带宽,NVFP4推理和训练性能分别达到了50/35 PFLOPS。与之前一样,『英伟达』还将两个Rubin GPU和一个Vera CPU组合在一起,带来了Vera Rubin Superchip,『芯片』之间通过NVLink-C2C互连技术连接。

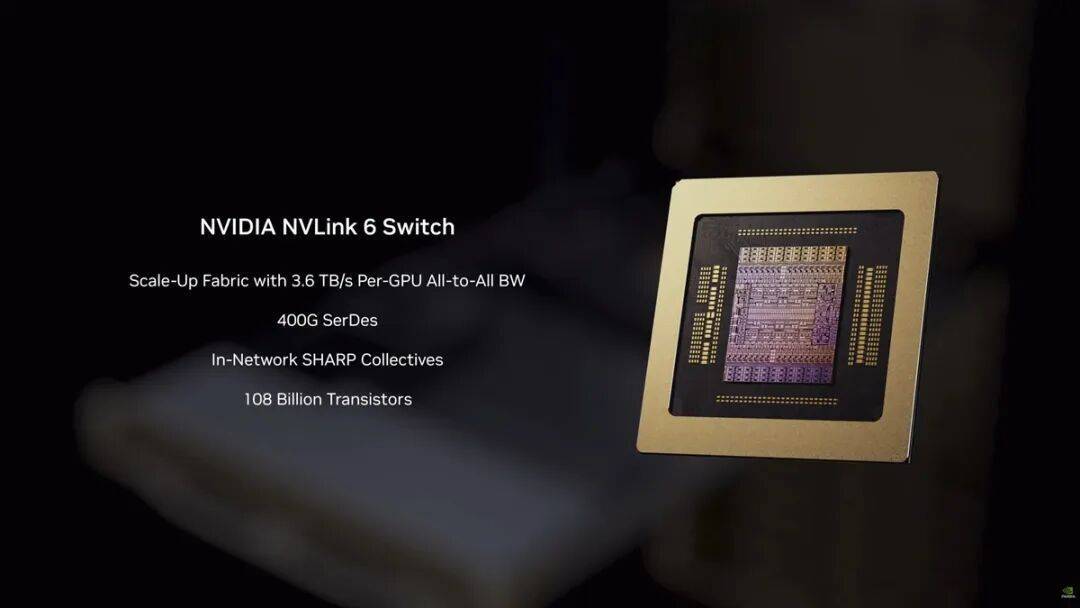

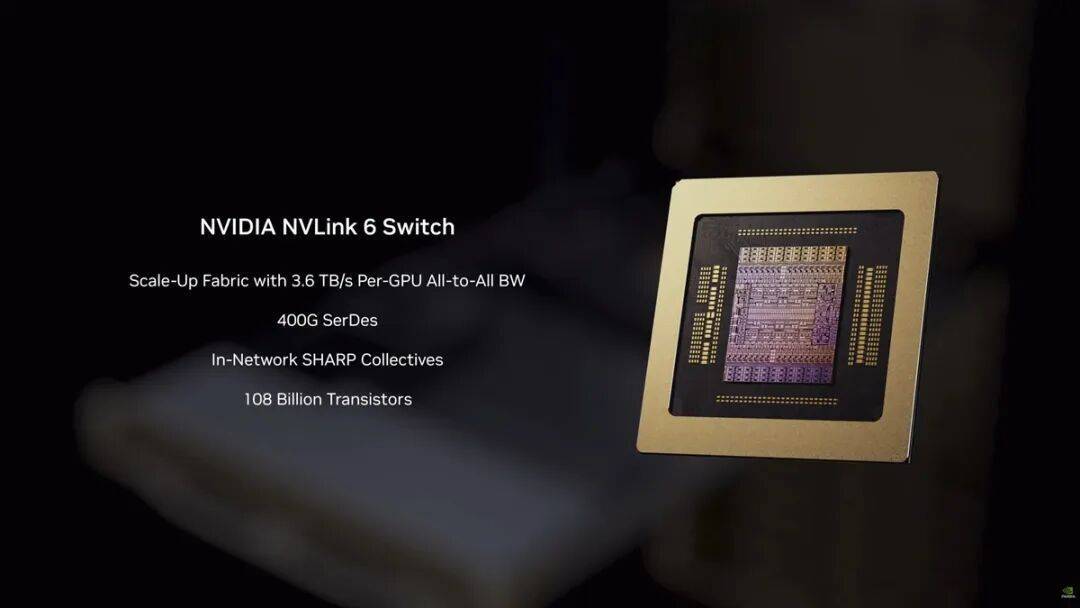

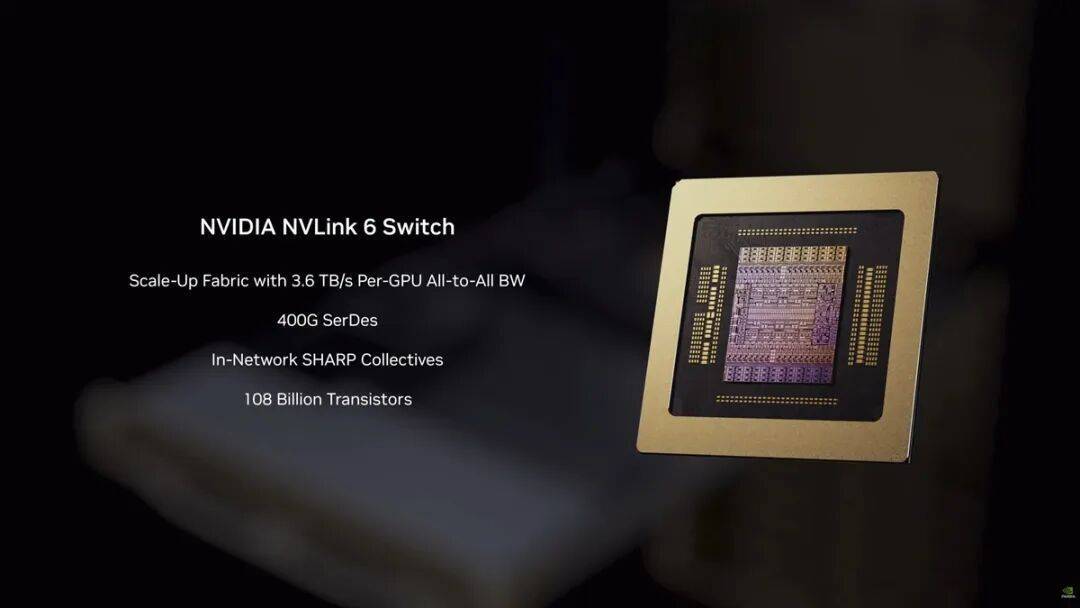

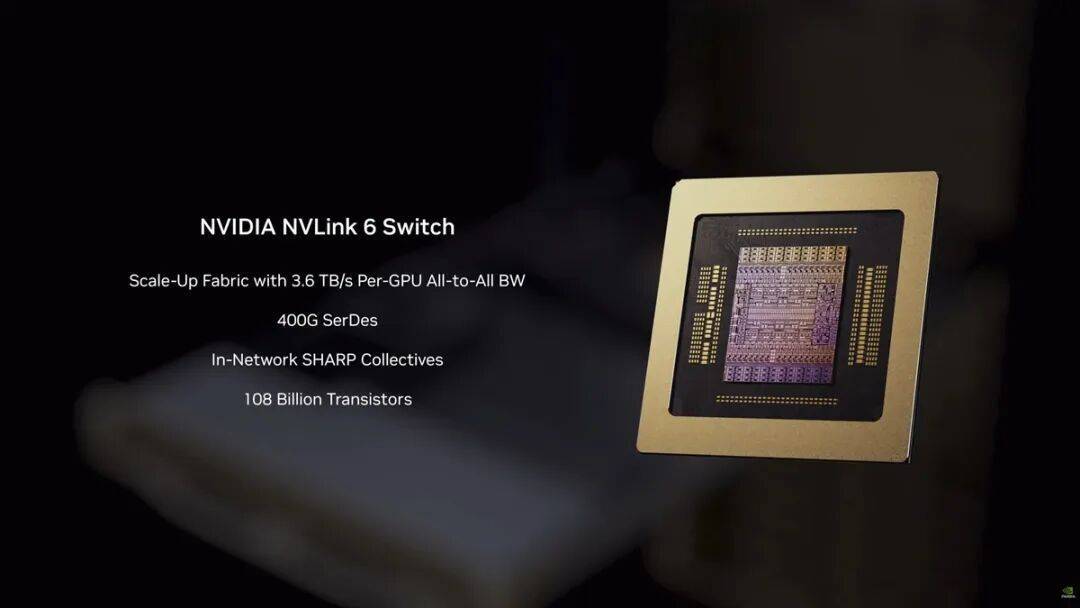

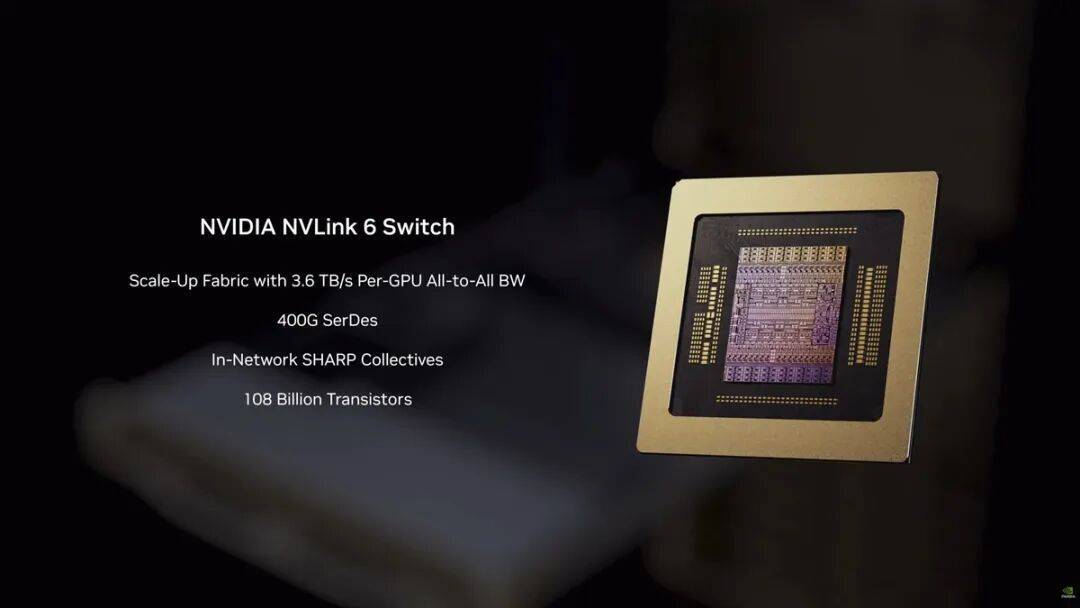

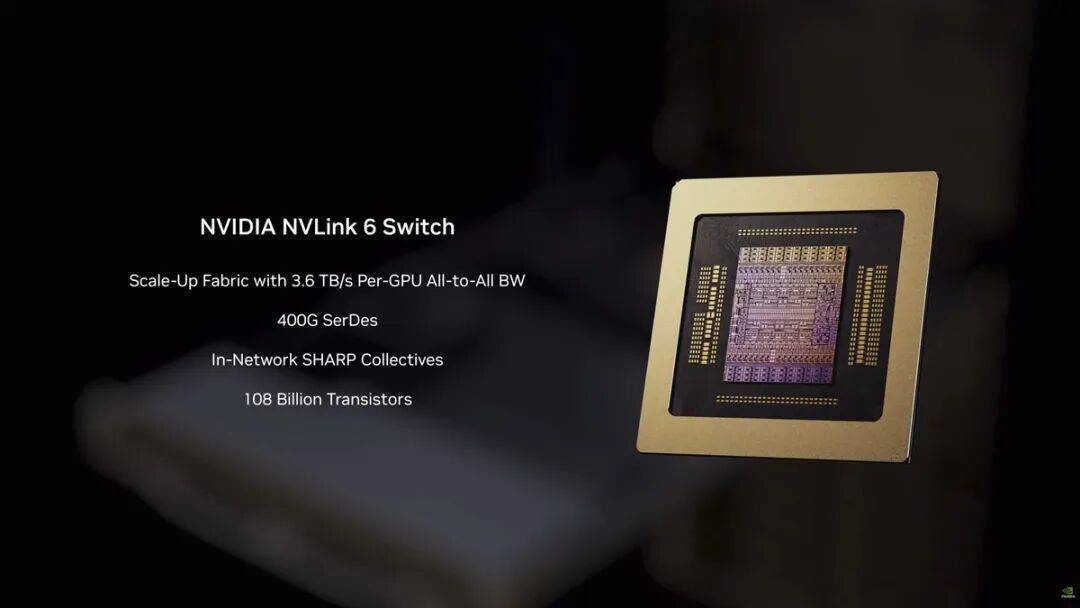

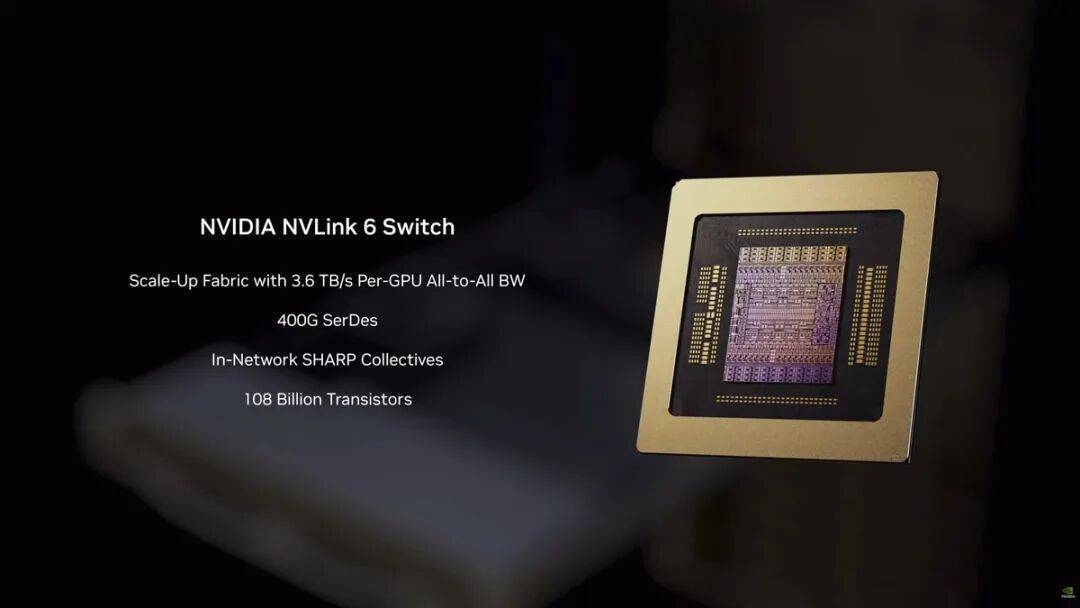

NVLink 6交换机是Rubin平台的扩展架构,让Vera Rubin NVL72的Rubin GPU能够作为一个单一的、紧密耦合的加速器运行,在通信主导的工作负载下实现均匀的延迟和持续的带宽。每个Rubin GPU都通过NVLink 6得到了3.6 TB/s的双向带宽,相比上一代产品带宽翻倍。

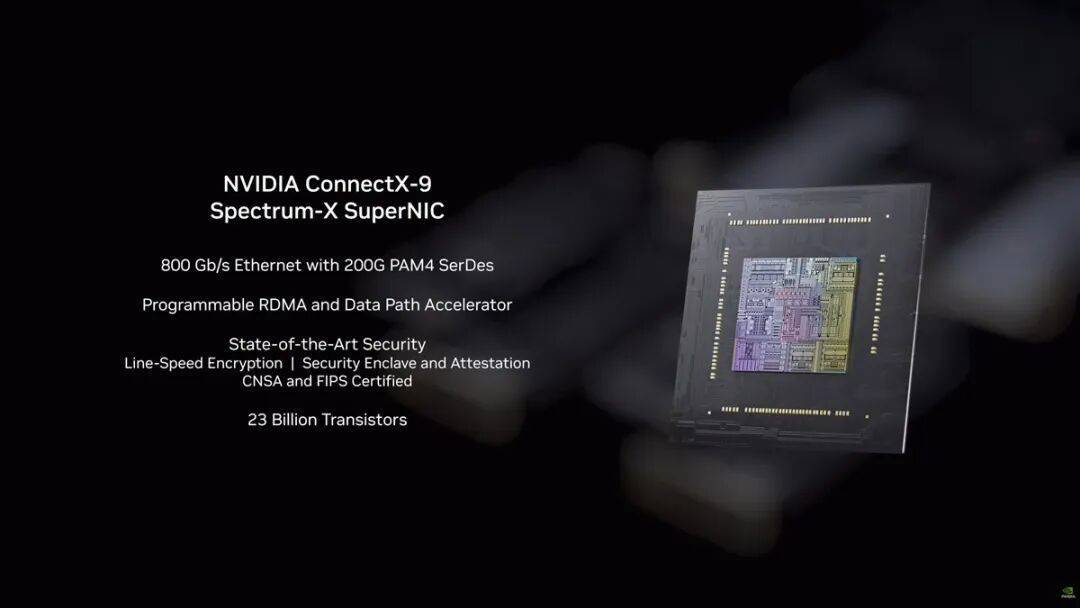

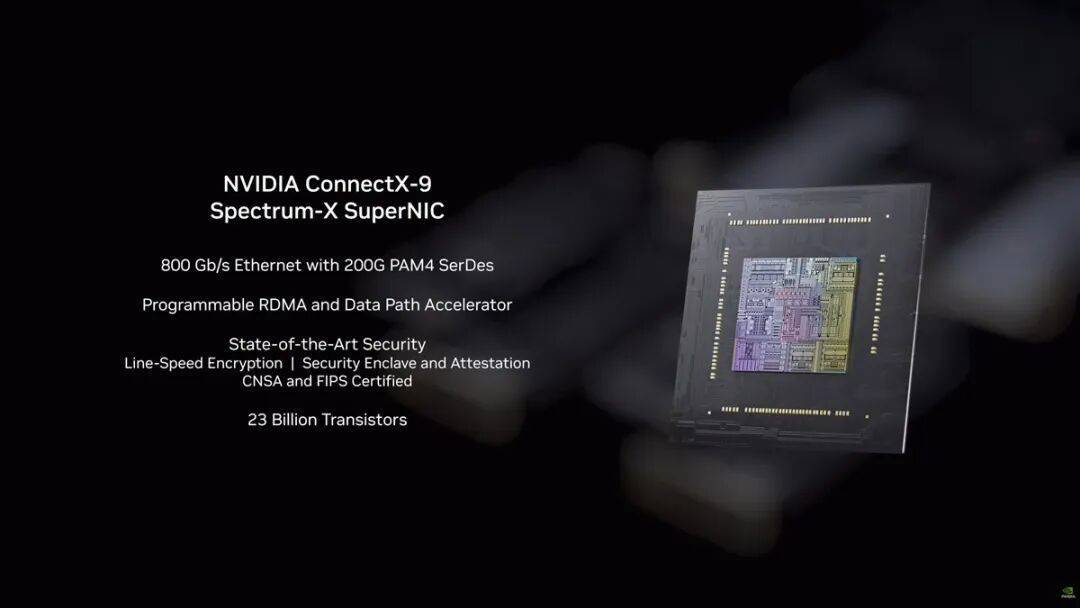

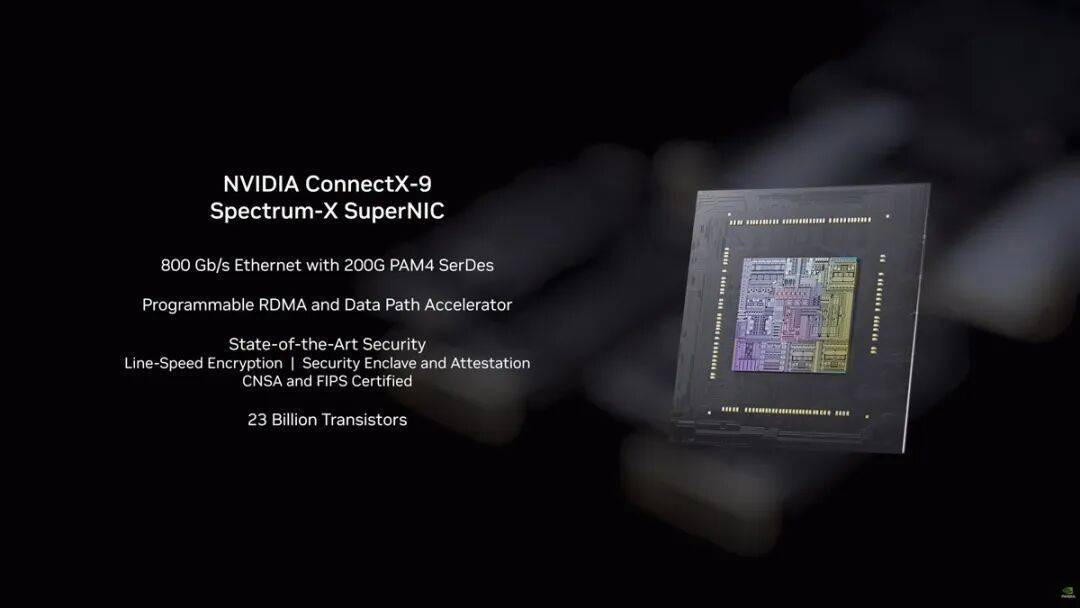

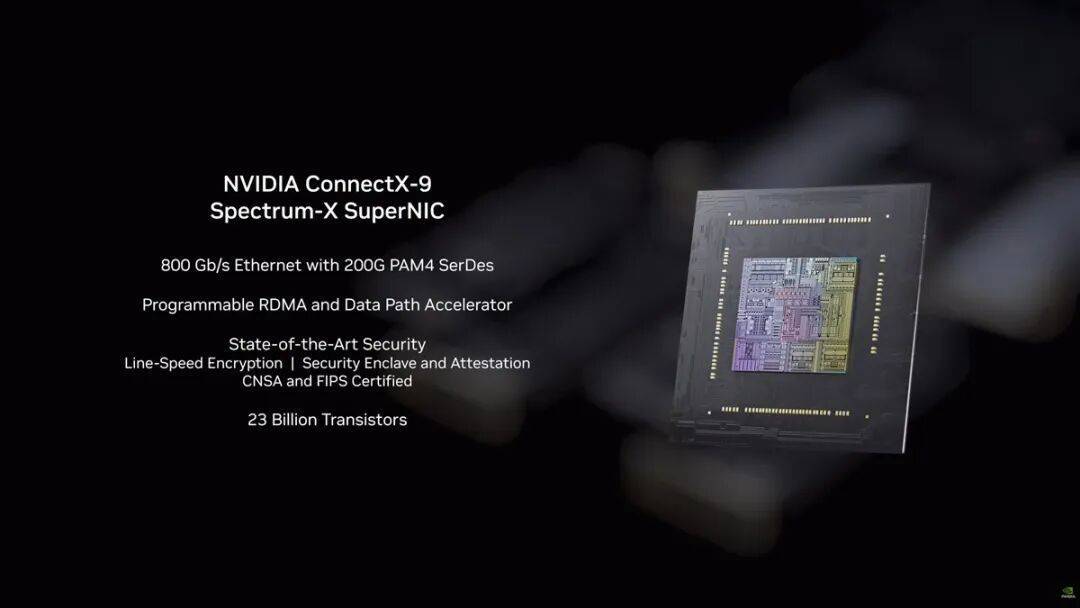

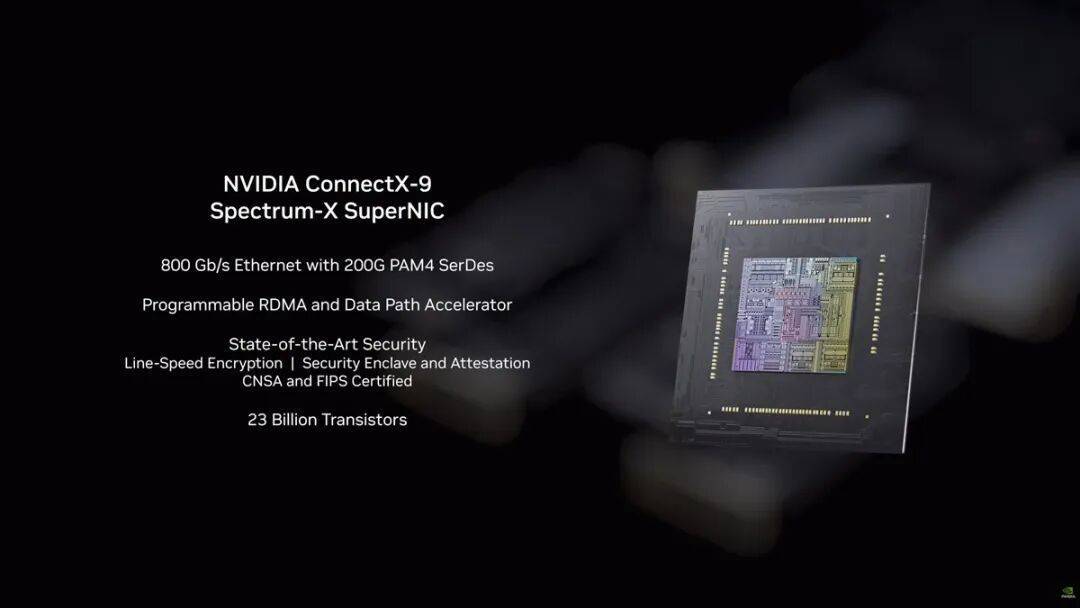

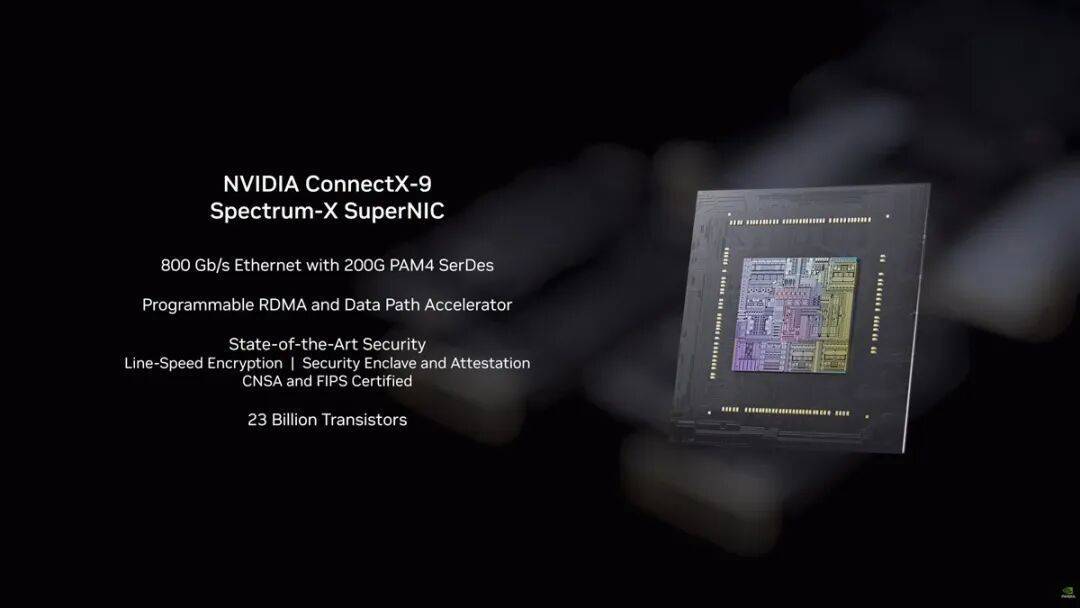

ConnectX-9作为Spectrum-X以太网架构的智能端点,提供可预测的横向扩展性能,并强制执行流量隔离和安全操作。在Vera Rubin NVL72里,每个计算托架包含四块ConnectX-9 SuperNIC网卡,为每个Rubin GPU提供1.6 Tb/s的网络带宽。

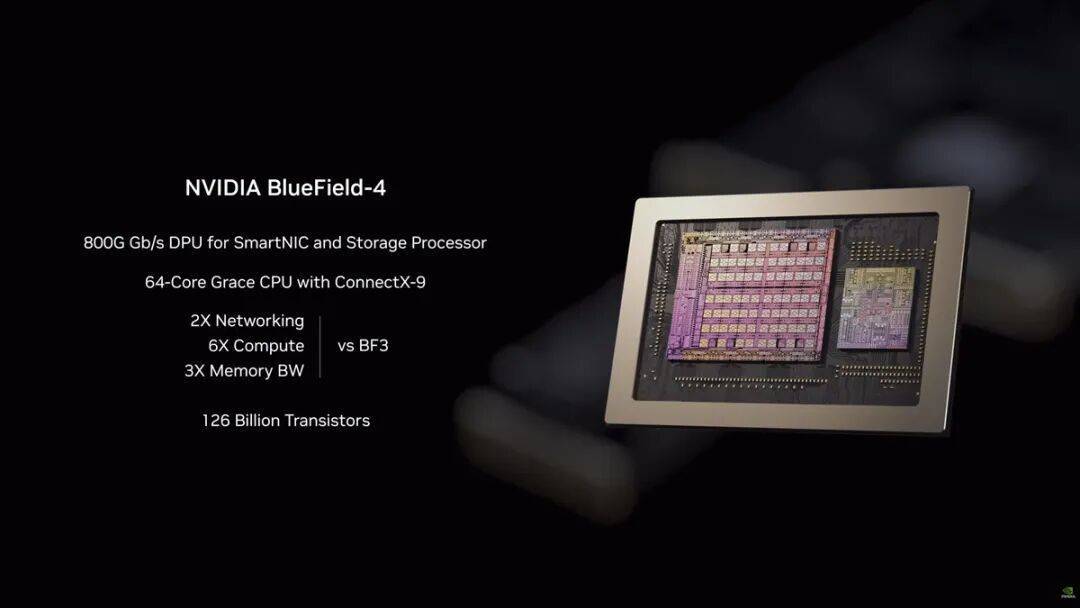

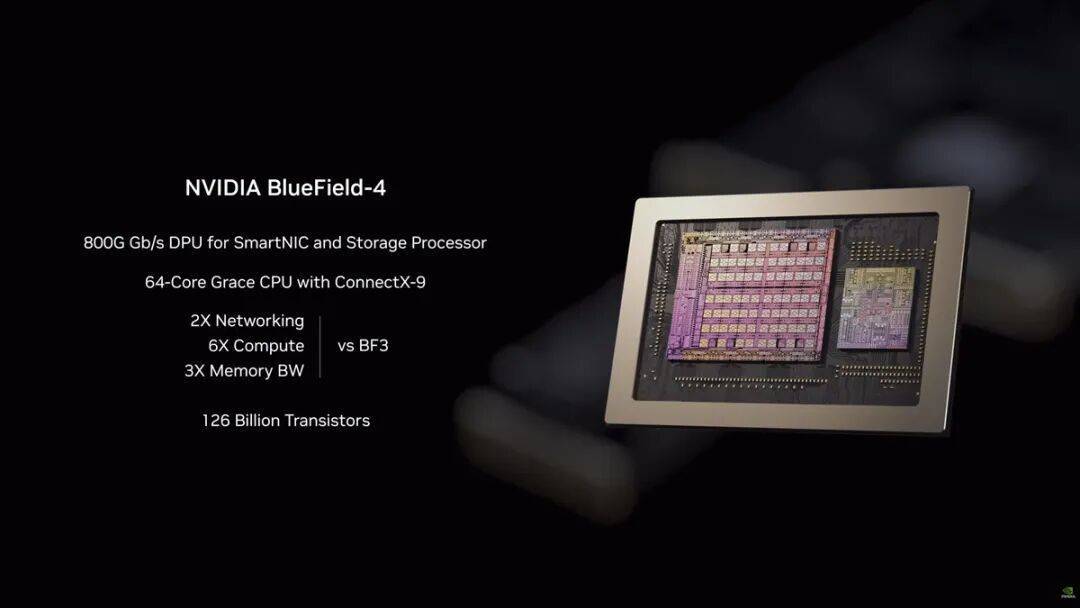

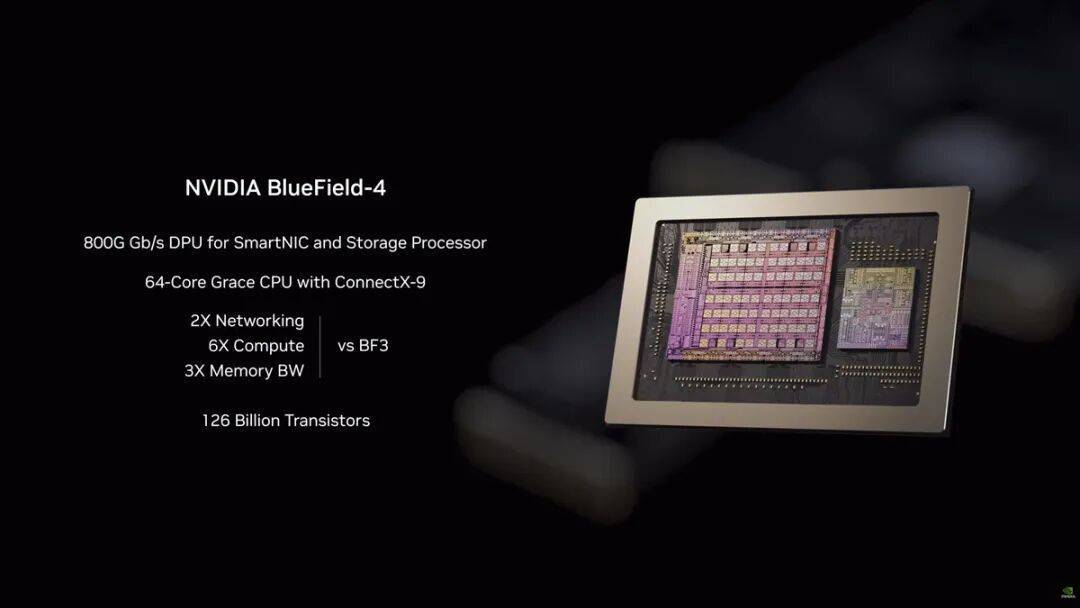

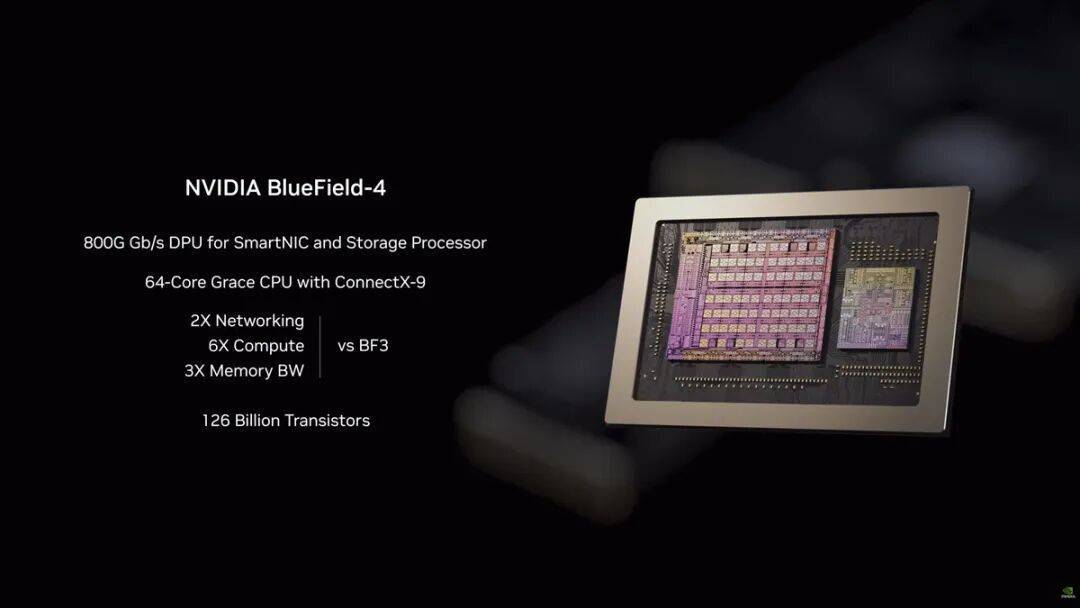

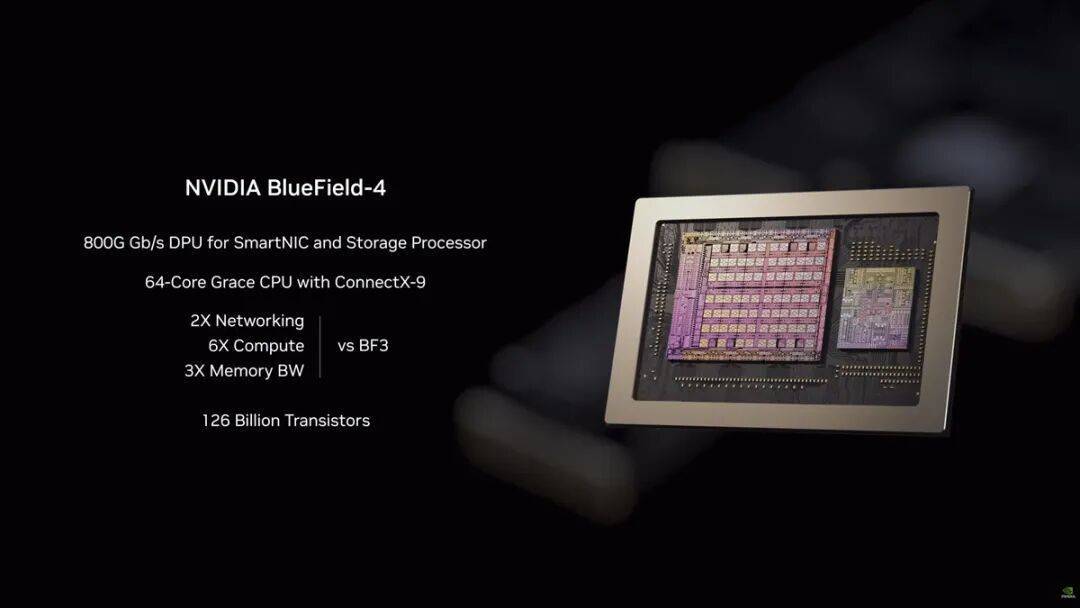

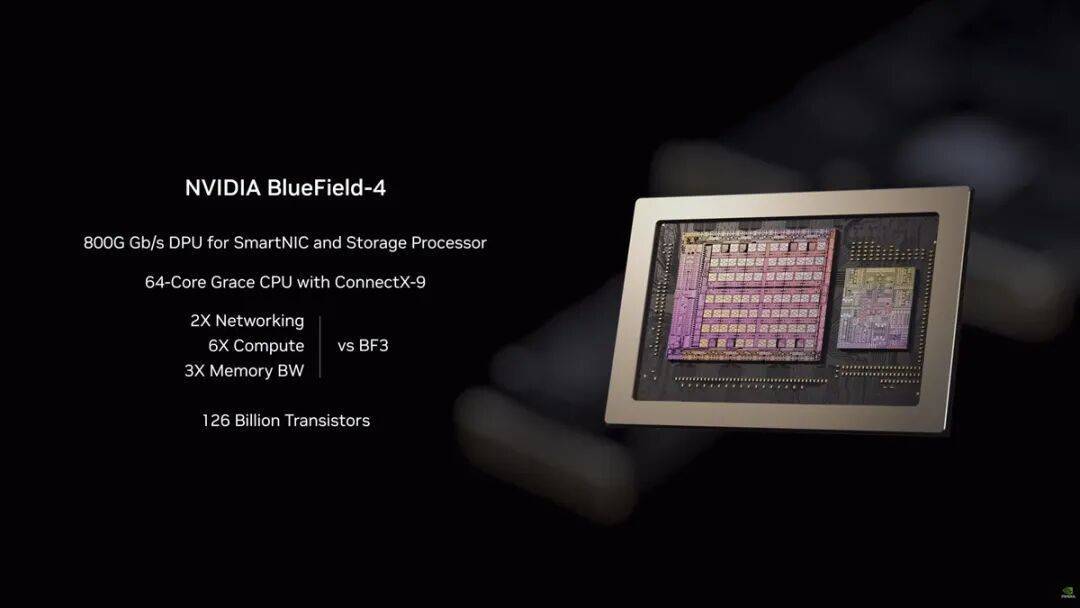

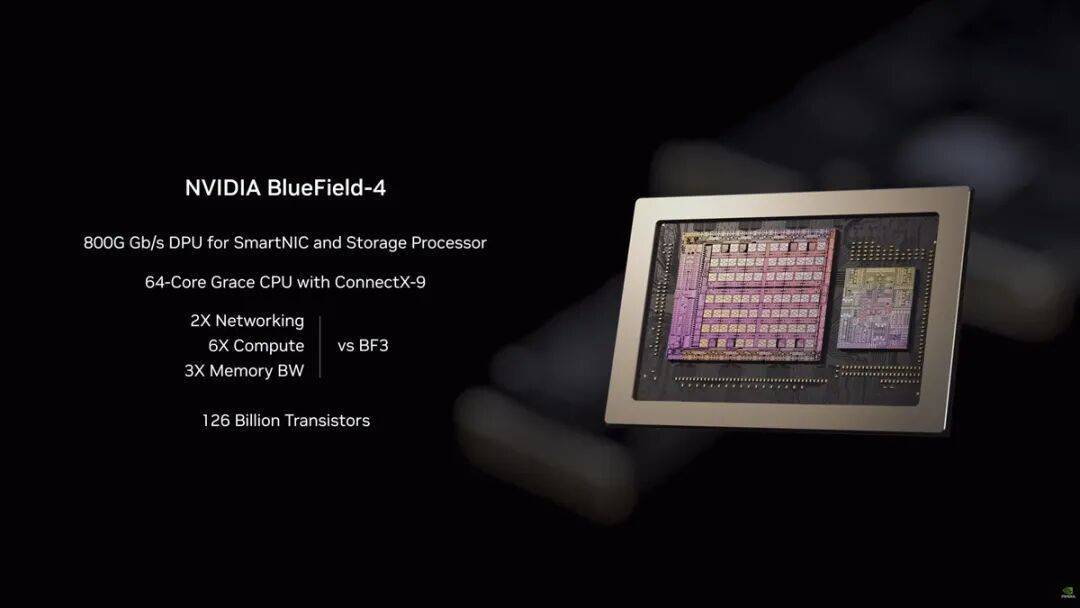

BlueField-4 DPU负责控制、安全、数据传输和编排,作为AI工厂的软件定义控制平面运行,独立于主机CPU和GPU实现安全性、隔离性和运行确定性。其集成了Grace CPU,共有64核心,远高于BlueField-3 DPU的16个Cortex ‑A78核心,同时还配有128GB LPDDR5X内存以及ConnectX-9,可提供高达800 Gb/s的超低延迟以太网或InfiniBand连接。

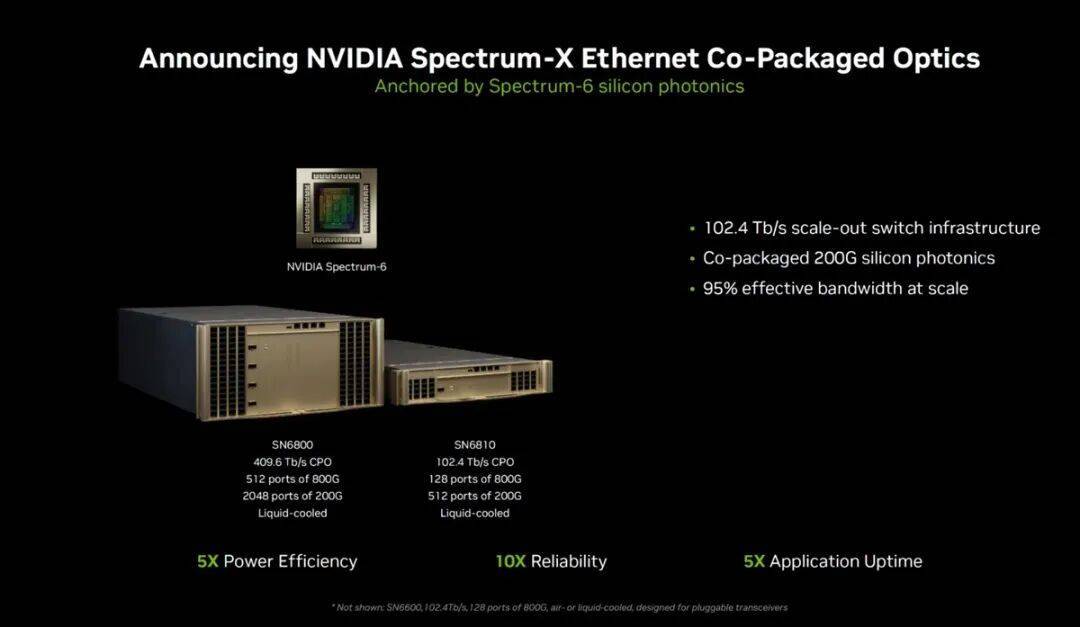

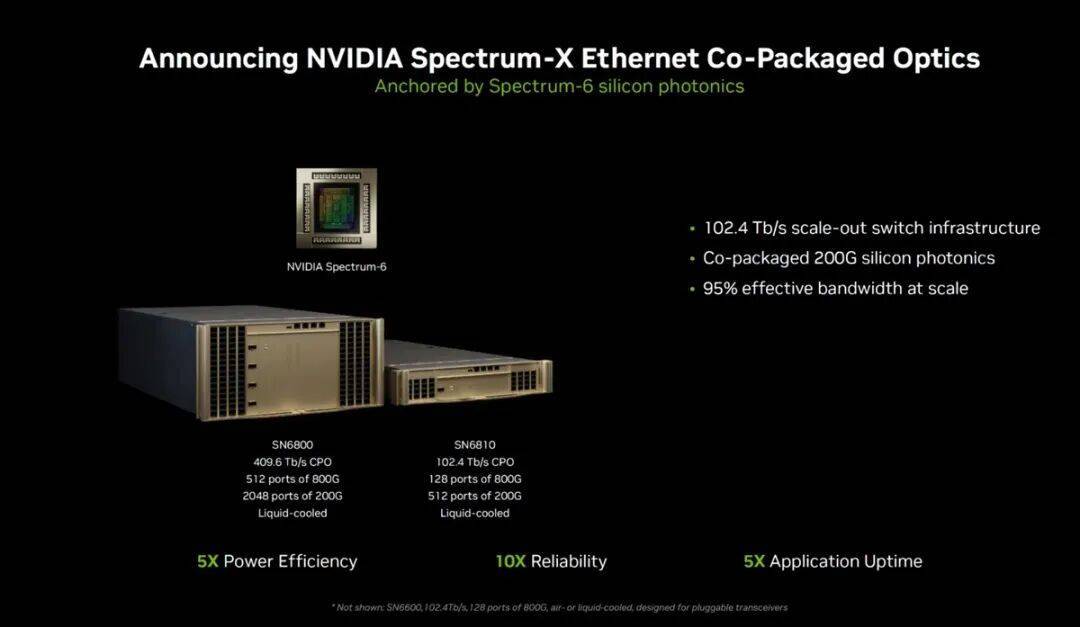

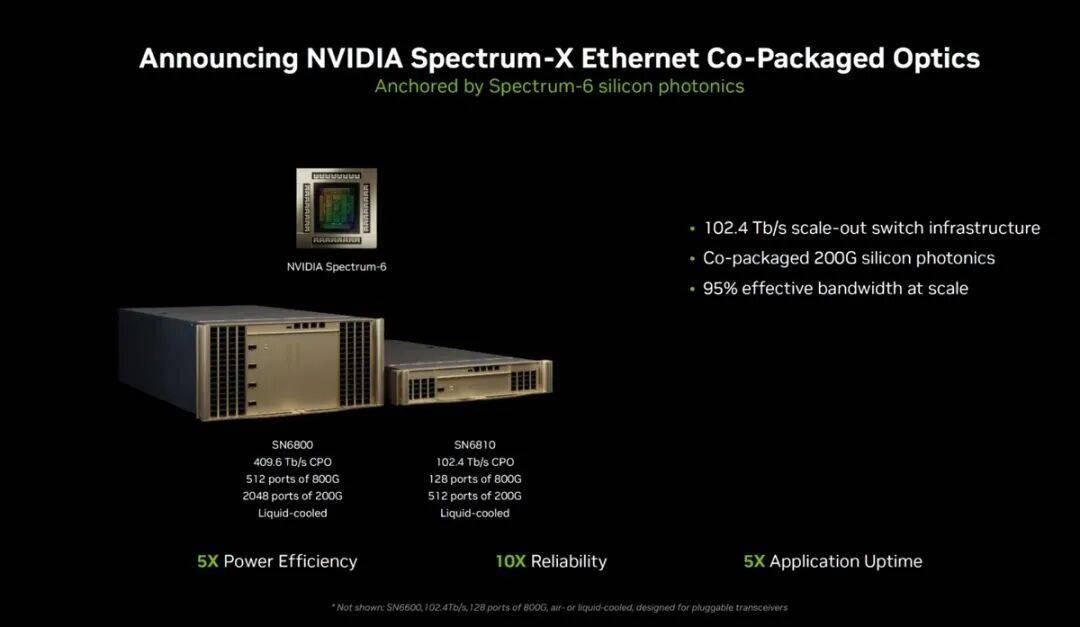

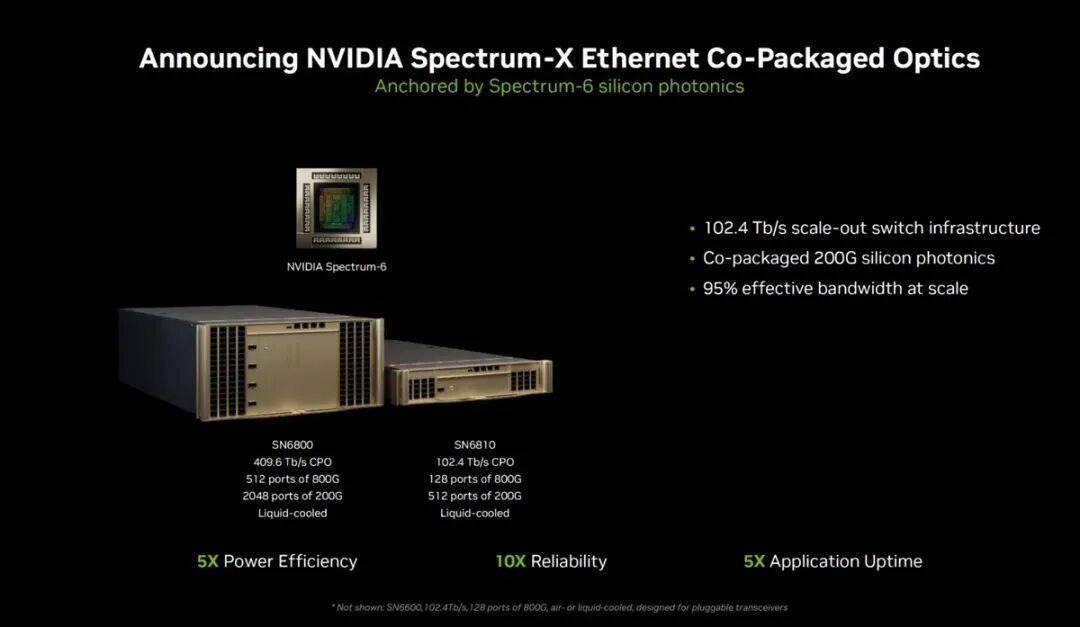

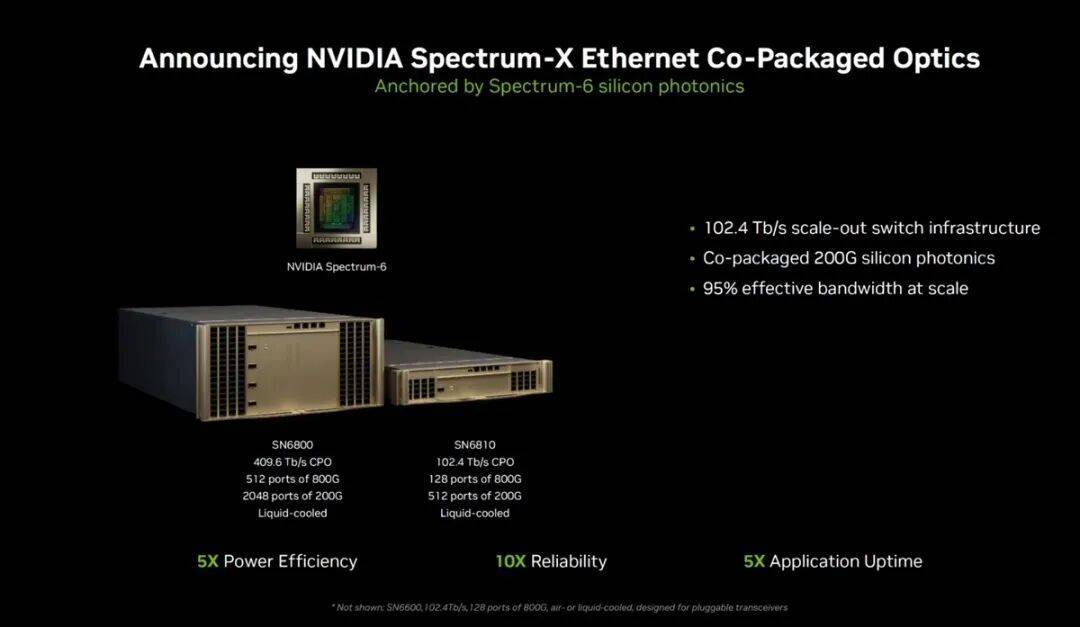

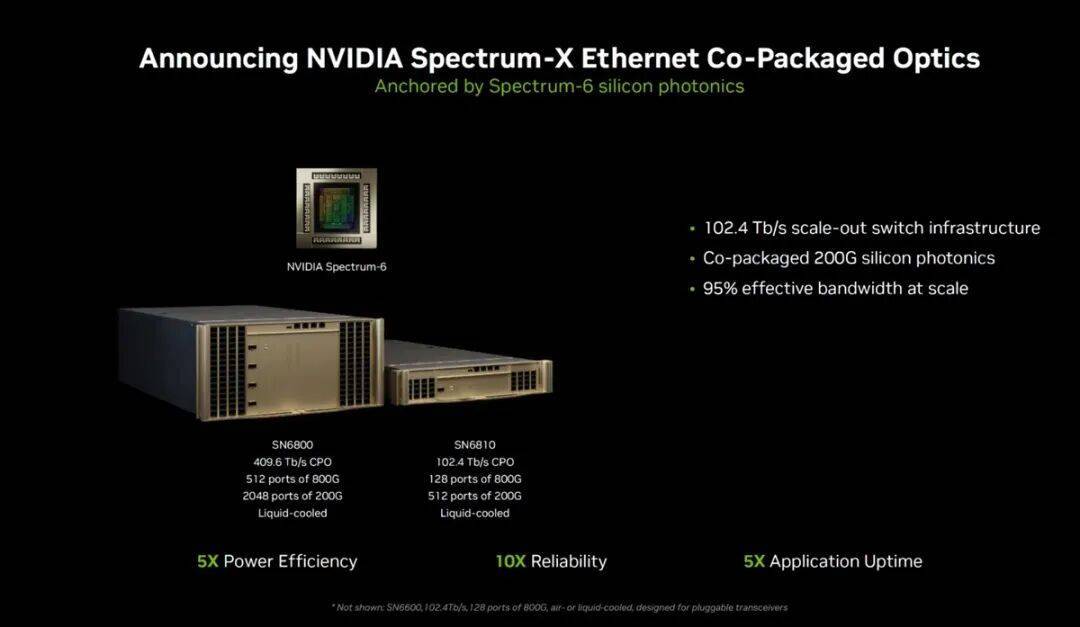

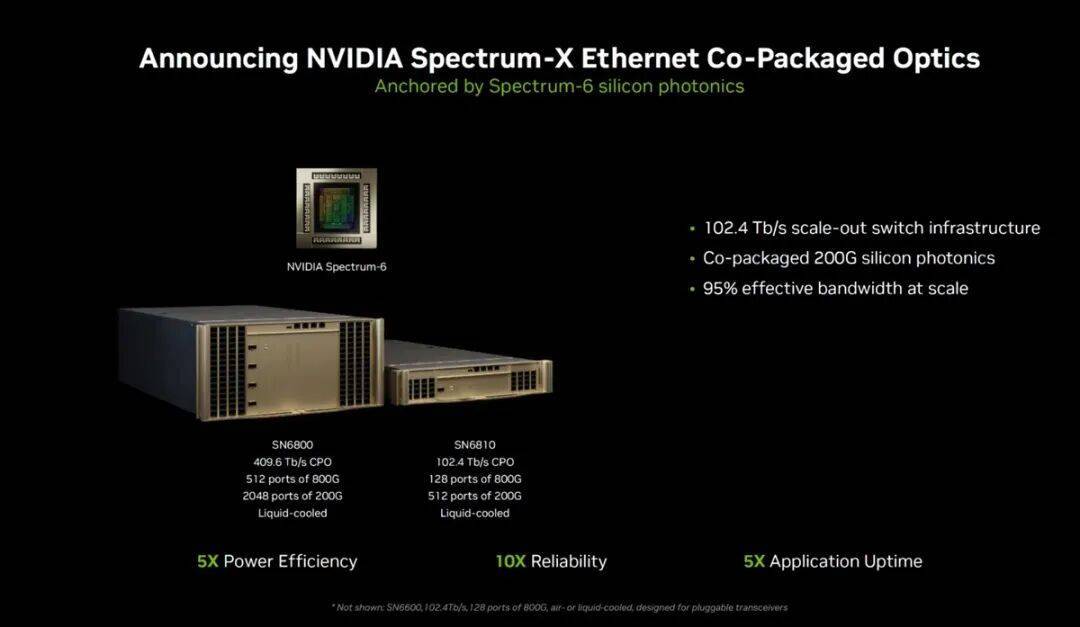

Spectrum-6以太网络交换机基于共封装光器件的新一代Spectrum-X技术,为Rubin平台引入了以太网光子学,可以更好地支持AI工厂的横向扩展和横向扩展部署。其针对AI工作负载进行了优化设计,具有高度同步性、突发性和非对称性。通过使用200G PAM4 SerDes,将每个交换『芯片』的带宽提升至102.4 Tb/s。

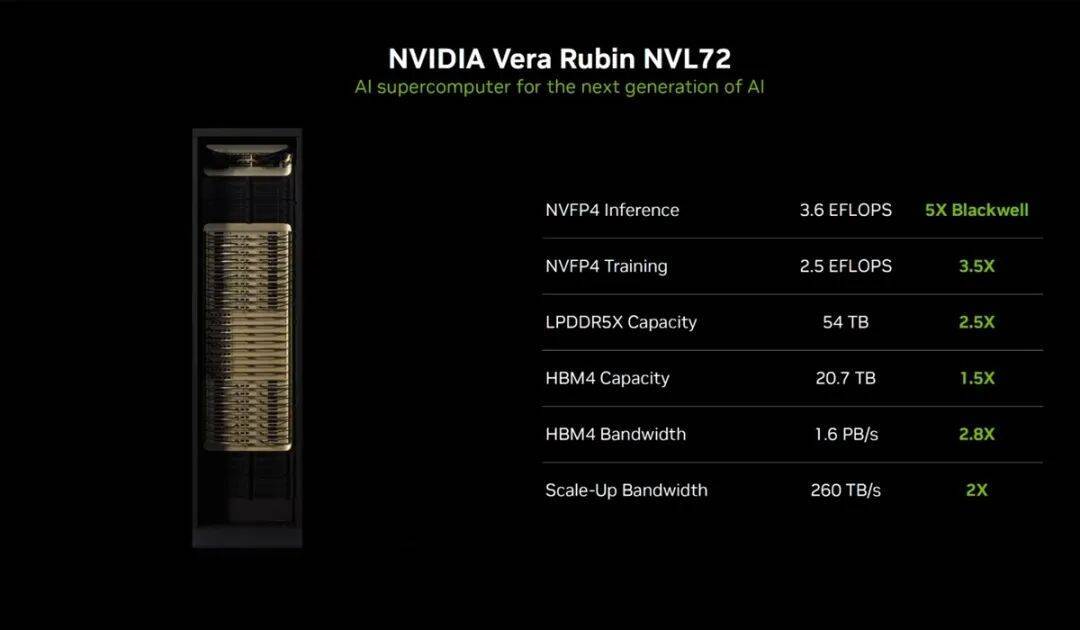

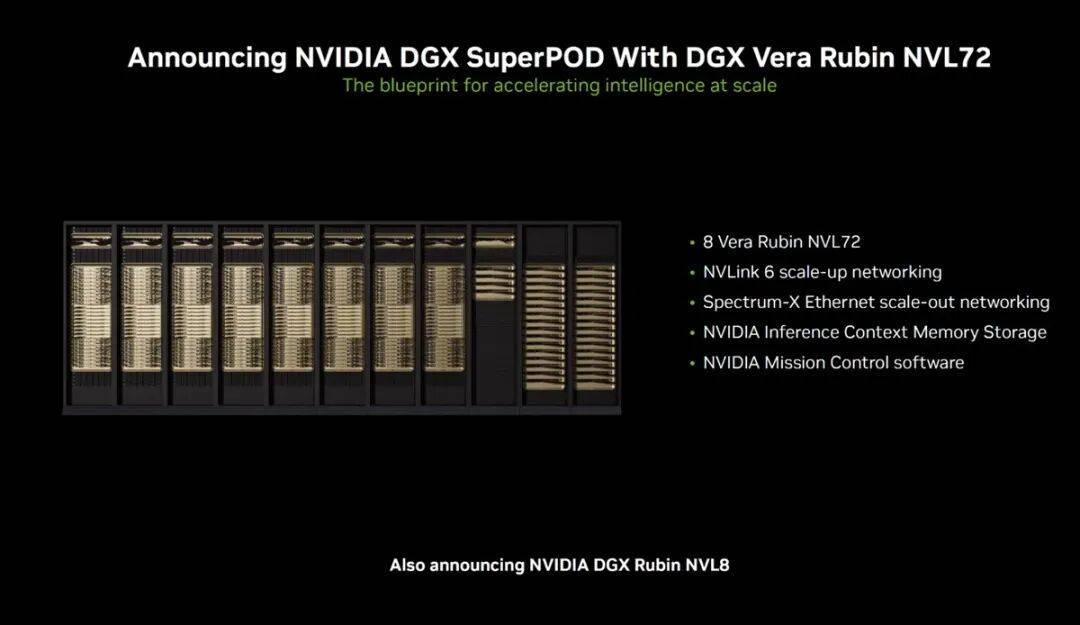

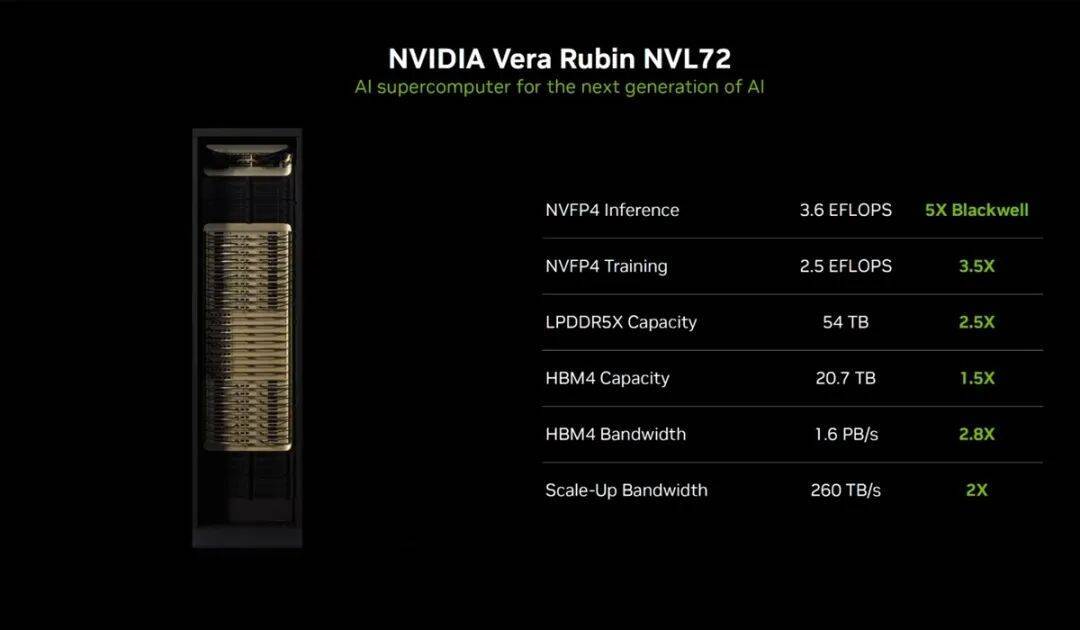

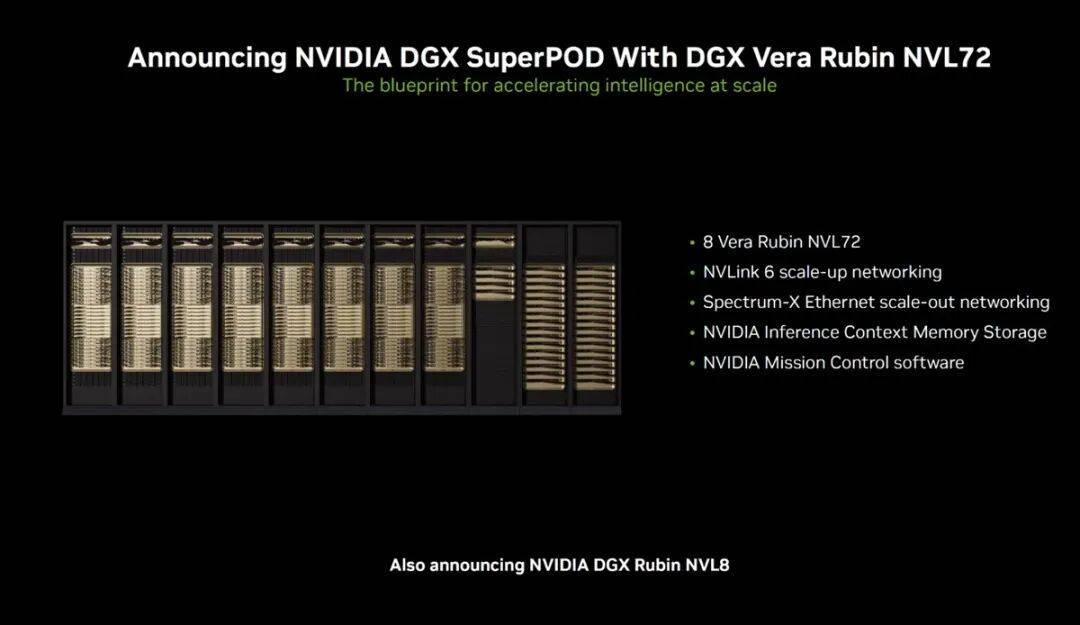

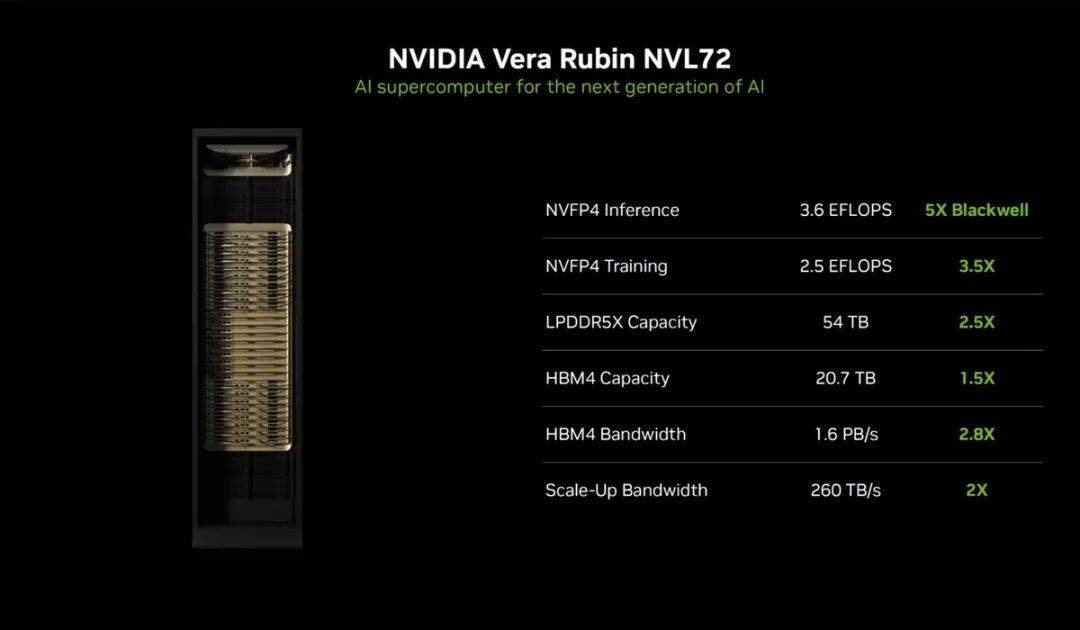

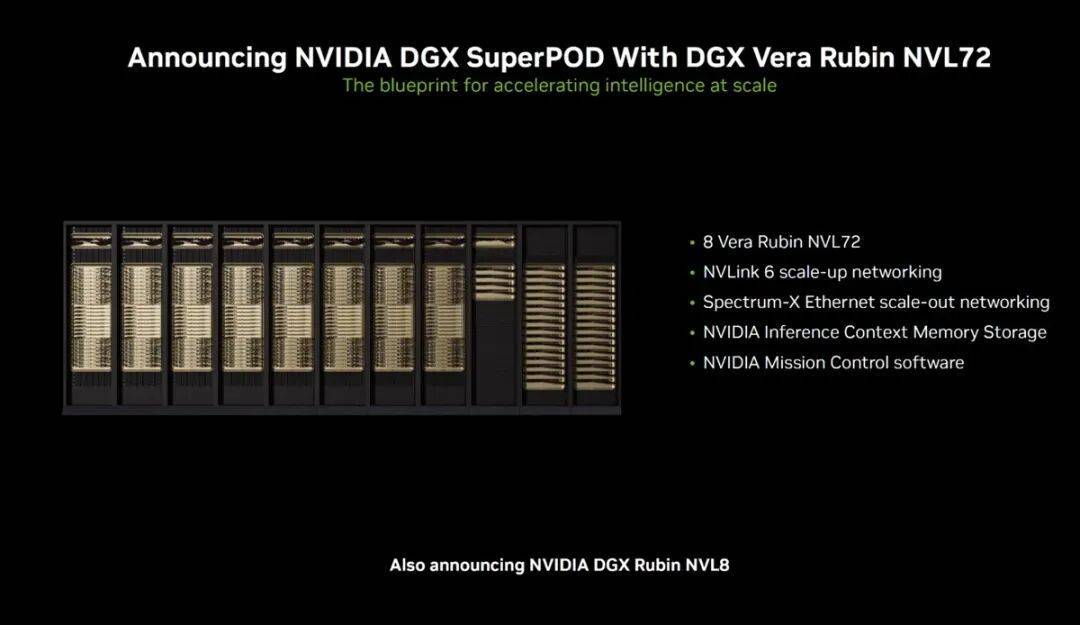

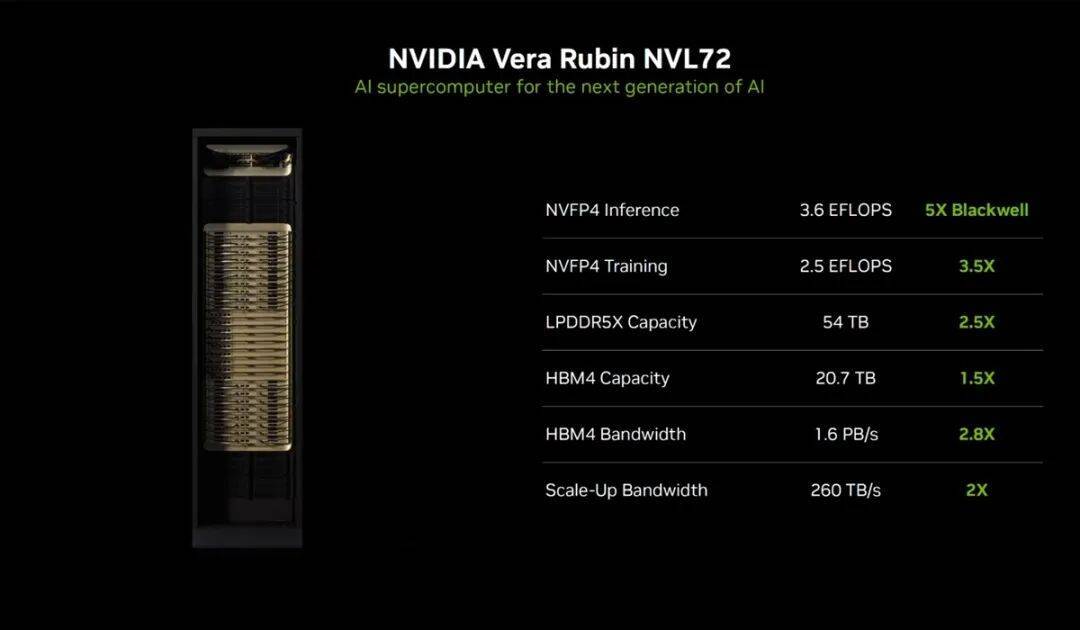

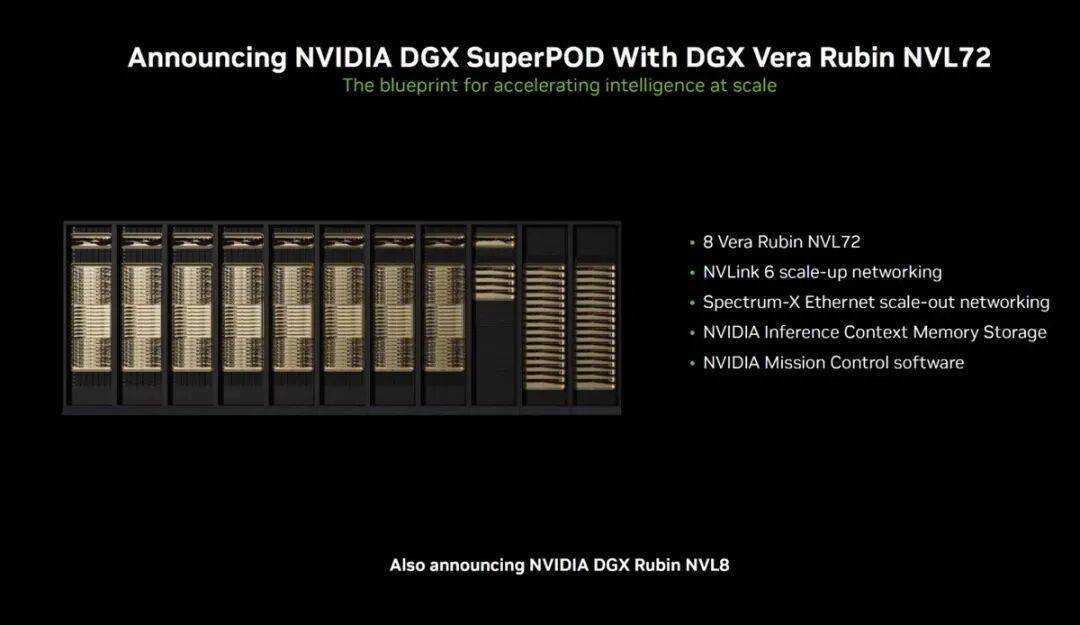

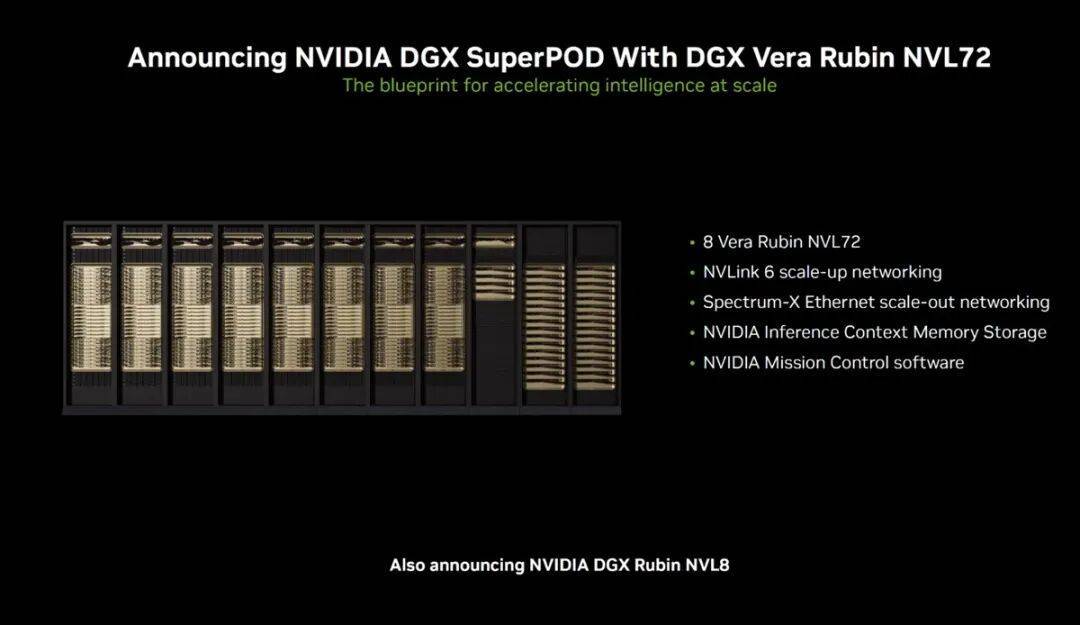

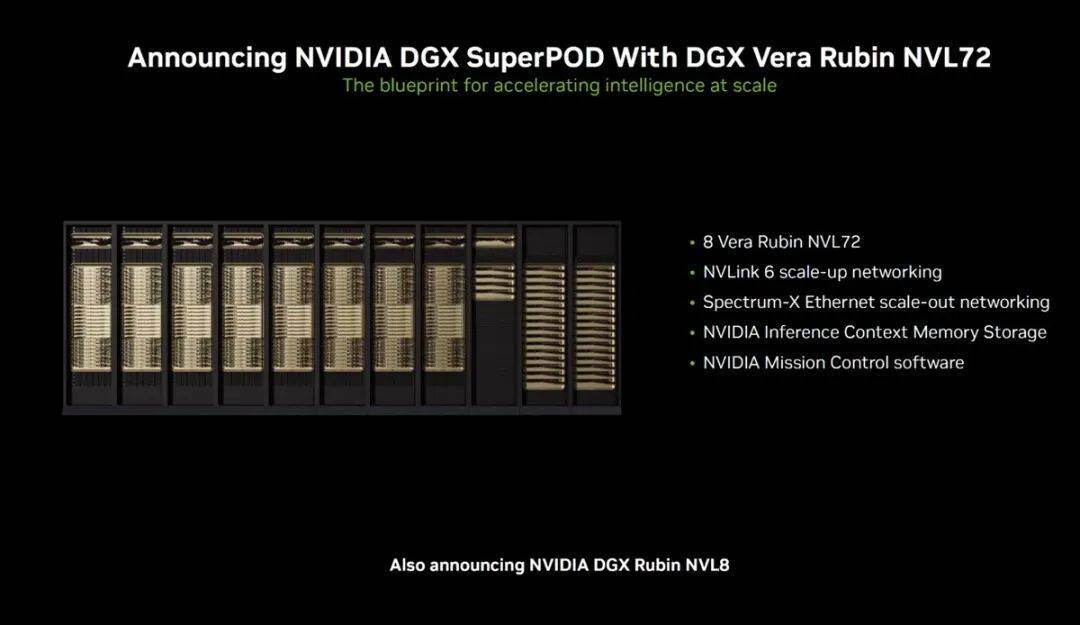

Vera Rubin NVL72基于第三代NVIDIA MGX机架设计,采用了模块化配置,支持热插拔。其拥有72个Rubin GPU、36个Vera CPU、以及18个BlueField-4 DPU,通过NVLink 6交换机协调工作,再利用Spectrum-X技术将平台扩展到机架之外,将八套Vera Rubin NVL72整合成NVIDIA DGX SuperPOD,NVFP4推理和训练性能分别达到了3.6/2.5 EFLOPS。

HGX Rubin NVL8系统是专门针对x86架构打造的生成式AI平台,通过NVLink技术连接8个Rubin GPU,能够高效加速AI训练、推理及高性能计算(HPC)等多元化工作负载,也能灵活地整合至DGX SuperPOD。

『英伟达』表示,包括亚马逊AWS、谷歌、微软Azure和甲骨文在内的多家云服务供应商将于2026年率先部署基于Vera Rubin的实例。

『英伟达』创始人兼首席执行官黄仁勋在今年的CES 2026上,正式了最新的Rubin平台,确认“已经全面投产”,开启新的AI之旅。

新平台由六款全新『芯片』组成,包括Vera CPU、Rubin GPU、NVLink 6交换机、ConnectX-9 SuperNIC、BlueField-4 DPU和Spectrum-6以太网络交换机,通过极致的协同设计,打造成一台性能惊人的AI超级计算机,大幅缩短AI训练时间并降低推理Token生成成本。

Rubin平台以Vera Florence Cooper Rubin命名,这是一位具有开创精神的美国天文学家,她的发现改变了人类对宇宙的理解。新平台包括NVIDIA Vera Rubin NVL72机架级扩展解决方案和NVIDIA HGX Rubin NVL8系统,引入了五项创新技术,分别为Vera CPU、新一代NVIDIA NVLink互连技术、第三代Transformer引擎、第三代NVIDIA机密计算、以及第二代RAS引擎。

Vera CPU拥有88个定制的Olympus核心,完全兼容Armv9.2,采用了“空间多线程(spatial multi-threading)”技术,可支持176个线程,每个核心拥有2M的L2缓存,另外还有162MB的统一L3缓存;最大支持1.5TB SOCAMM LPDDR5X内存,提供了1.2 TB/s的内存带宽;支持超高速NVLink-C2C互连技术,对应带宽可达到1.8 TB/s;支持PCIe 6.0和CXL 3.1标准。

Rubin GPU由两颗Die组成,集成了224个SM,第六代Tensor Core,HBM4提供了22 TB/s的带宽,每颗GPU拥有3.6 TB/s的NVLink带宽,NVFP4推理和训练性能分别达到了50/35 PFLOPS。与之前一样,『英伟达』还将两个Rubin GPU和一个Vera CPU组合在一起,带来了Vera Rubin Superchip,『芯片』之间通过NVLink-C2C互连技术连接。

NVLink 6交换机是Rubin平台的扩展架构,让Vera Rubin NVL72的Rubin GPU能够作为一个单一的、紧密耦合的加速器运行,在通信主导的工作负载下实现均匀的延迟和持续的带宽。每个Rubin GPU都通过NVLink 6得到了3.6 TB/s的双向带宽,相比上一代产品带宽翻倍。

ConnectX-9作为Spectrum-X以太网架构的智能端点,提供可预测的横向扩展性能,并强制执行流量隔离和安全操作。在Vera Rubin NVL72里,每个计算托架包含四块ConnectX-9 SuperNIC网卡,为每个Rubin GPU提供1.6 Tb/s的网络带宽。

BlueField-4 DPU负责控制、安全、数据传输和编排,作为AI工厂的软件定义控制平面运行,独立于主机CPU和GPU实现安全性、隔离性和运行确定性。其集成了Grace CPU,共有64核心,远高于BlueField-3 DPU的16个Cortex ‑A78核心,同时还配有128GB LPDDR5X内存以及ConnectX-9,可提供高达800 Gb/s的超低延迟以太网或InfiniBand连接。

Spectrum-6以太网络交换机基于共封装光器件的新一代Spectrum-X技术,为Rubin平台引入了以太网光子学,可以更好地支持AI工厂的横向扩展和横向扩展部署。其针对AI工作负载进行了优化设计,具有高度同步性、突发性和非对称性。通过使用200G PAM4 SerDes,将每个交换『芯片』的带宽提升至102.4 Tb/s。

Vera Rubin NVL72基于第三代NVIDIA MGX机架设计,采用了模块化配置,支持热插拔。其拥有72个Rubin GPU、36个Vera CPU、以及18个BlueField-4 DPU,通过NVLink 6交换机协调工作,再利用Spectrum-X技术将平台扩展到机架之外,将八套Vera Rubin NVL72整合成NVIDIA DGX SuperPOD,NVFP4推理和训练性能分别达到了3.6/2.5 EFLOPS。

HGX Rubin NVL8系统是专门针对x86架构打造的生成式AI平台,通过NVLink技术连接8个Rubin GPU,能够高效加速AI训练、推理及高性能计算(HPC)等多元化工作负载,也能灵活地整合至DGX SuperPOD。

『英伟达』表示,包括亚马逊AWS、谷歌、微软Azure和甲骨文在内的多家云服务供应商将于2026年率先部署基于Vera Rubin的实例。

『英伟达』创始人兼首席执行官黄仁勋在今年的CES 2026上,正式了最新的Rubin平台,确认“已经全面投产”,开启新的AI之旅。

新平台由六款全新『芯片』组成,包括Vera CPU、Rubin GPU、NVLink 6交换机、ConnectX-9 SuperNIC、BlueField-4 DPU和Spectrum-6以太网络交换机,通过极致的协同设计,打造成一台性能惊人的AI超级计算机,大幅缩短AI训练时间并降低推理Token生成成本。

Rubin平台以Vera Florence Cooper Rubin命名,这是一位具有开创精神的美国天文学家,她的发现改变了人类对宇宙的理解。新平台包括NVIDIA Vera Rubin NVL72机架级扩展解决方案和NVIDIA HGX Rubin NVL8系统,引入了五项创新技术,分别为Vera CPU、新一代NVIDIA NVLink互连技术、第三代Transformer引擎、第三代NVIDIA机密计算、以及第二代RAS引擎。

Vera CPU拥有88个定制的Olympus核心,完全兼容Armv9.2,采用了“空间多线程(spatial multi-threading)”技术,可支持176个线程,每个核心拥有2M的L2缓存,另外还有162MB的统一L3缓存;最大支持1.5TB SOCAMM LPDDR5X内存,提供了1.2 TB/s的内存带宽;支持超高速NVLink-C2C互连技术,对应带宽可达到1.8 TB/s;支持PCIe 6.0和CXL 3.1标准。

Rubin GPU由两颗Die组成,集成了224个SM,第六代Tensor Core,HBM4提供了22 TB/s的带宽,每颗GPU拥有3.6 TB/s的NVLink带宽,NVFP4推理和训练性能分别达到了50/35 PFLOPS。与之前一样,『英伟达』还将两个Rubin GPU和一个Vera CPU组合在一起,带来了Vera Rubin Superchip,『芯片』之间通过NVLink-C2C互连技术连接。

NVLink 6交换机是Rubin平台的扩展架构,让Vera Rubin NVL72的Rubin GPU能够作为一个单一的、紧密耦合的加速器运行,在通信主导的工作负载下实现均匀的延迟和持续的带宽。每个Rubin GPU都通过NVLink 6得到了3.6 TB/s的双向带宽,相比上一代产品带宽翻倍。

ConnectX-9作为Spectrum-X以太网架构的智能端点,提供可预测的横向扩展性能,并强制执行流量隔离和安全操作。在Vera Rubin NVL72里,每个计算托架包含四块ConnectX-9 SuperNIC网卡,为每个Rubin GPU提供1.6 Tb/s的网络带宽。

BlueField-4 DPU负责控制、安全、数据传输和编排,作为AI工厂的软件定义控制平面运行,独立于主机CPU和GPU实现安全性、隔离性和运行确定性。其集成了Grace CPU,共有64核心,远高于BlueField-3 DPU的16个Cortex ‑A78核心,同时还配有128GB LPDDR5X内存以及ConnectX-9,可提供高达800 Gb/s的超低延迟以太网或InfiniBand连接。

Spectrum-6以太网络交换机基于共封装光器件的新一代Spectrum-X技术,为Rubin平台引入了以太网光子学,可以更好地支持AI工厂的横向扩展和横向扩展部署。其针对AI工作负载进行了优化设计,具有高度同步性、突发性和非对称性。通过使用200G PAM4 SerDes,将每个交换『芯片』的带宽提升至102.4 Tb/s。

Vera Rubin NVL72基于第三代NVIDIA MGX机架设计,采用了模块化配置,支持热插拔。其拥有72个Rubin GPU、36个Vera CPU、以及18个BlueField-4 DPU,通过NVLink 6交换机协调工作,再利用Spectrum-X技术将平台扩展到机架之外,将八套Vera Rubin NVL72整合成NVIDIA DGX SuperPOD,NVFP4推理和训练性能分别达到了3.6/2.5 EFLOPS。

HGX Rubin NVL8系统是专门针对x86架构打造的生成式AI平台,通过NVLink技术连接8个Rubin GPU,能够高效加速AI训练、推理及高性能计算(HPC)等多元化工作负载,也能灵活地整合至DGX SuperPOD。

『英伟达』表示,包括亚马逊AWS、谷歌、微软Azure和甲骨文在内的多家云服务供应商将于2026年率先部署基于Vera Rubin的实例。

『英伟达』创始人兼首席执行官黄仁勋在今年的CES 2026上,正式了最新的Rubin平台,确认“已经全面投产”,开启新的AI之旅。

新平台由六款全新『芯片』组成,包括Vera CPU、Rubin GPU、NVLink 6交换机、ConnectX-9 SuperNIC、BlueField-4 DPU和Spectrum-6以太网络交换机,通过极致的协同设计,打造成一台性能惊人的AI超级计算机,大幅缩短AI训练时间并降低推理Token生成成本。

Rubin平台以Vera Florence Cooper Rubin命名,这是一位具有开创精神的美国天文学家,她的发现改变了人类对宇宙的理解。新平台包括NVIDIA Vera Rubin NVL72机架级扩展解决方案和NVIDIA HGX Rubin NVL8系统,引入了五项创新技术,分别为Vera CPU、新一代NVIDIA NVLink互连技术、第三代Transformer引擎、第三代NVIDIA机密计算、以及第二代RAS引擎。

Vera CPU拥有88个定制的Olympus核心,完全兼容Armv9.2,采用了“空间多线程(spatial multi-threading)”技术,可支持176个线程,每个核心拥有2M的L2缓存,另外还有162MB的统一L3缓存;最大支持1.5TB SOCAMM LPDDR5X内存,提供了1.2 TB/s的内存带宽;支持超高速NVLink-C2C互连技术,对应带宽可达到1.8 TB/s;支持PCIe 6.0和CXL 3.1标准。

Rubin GPU由两颗Die组成,集成了224个SM,第六代Tensor Core,HBM4提供了22 TB/s的带宽,每颗GPU拥有3.6 TB/s的NVLink带宽,NVFP4推理和训练性能分别达到了50/35 PFLOPS。与之前一样,『英伟达』还将两个Rubin GPU和一个Vera CPU组合在一起,带来了Vera Rubin Superchip,『芯片』之间通过NVLink-C2C互连技术连接。

NVLink 6交换机是Rubin平台的扩展架构,让Vera Rubin NVL72的Rubin GPU能够作为一个单一的、紧密耦合的加速器运行,在通信主导的工作负载下实现均匀的延迟和持续的带宽。每个Rubin GPU都通过NVLink 6得到了3.6 TB/s的双向带宽,相比上一代产品带宽翻倍。

ConnectX-9作为Spectrum-X以太网架构的智能端点,提供可预测的横向扩展性能,并强制执行流量隔离和安全操作。在Vera Rubin NVL72里,每个计算托架包含四块ConnectX-9 SuperNIC网卡,为每个Rubin GPU提供1.6 Tb/s的网络带宽。

BlueField-4 DPU负责控制、安全、数据传输和编排,作为AI工厂的软件定义控制平面运行,独立于主机CPU和GPU实现安全性、隔离性和运行确定性。其集成了Grace CPU,共有64核心,远高于BlueField-3 DPU的16个Cortex ‑A78核心,同时还配有128GB LPDDR5X内存以及ConnectX-9,可提供高达800 Gb/s的超低延迟以太网或InfiniBand连接。

Spectrum-6以太网络交换机基于共封装光器件的新一代Spectrum-X技术,为Rubin平台引入了以太网光子学,可以更好地支持AI工厂的横向扩展和横向扩展部署。其针对AI工作负载进行了优化设计,具有高度同步性、突发性和非对称性。通过使用200G PAM4 SerDes,将每个交换『芯片』的带宽提升至102.4 Tb/s。

Vera Rubin NVL72基于第三代NVIDIA MGX机架设计,采用了模块化配置,支持热插拔。其拥有72个Rubin GPU、36个Vera CPU、以及18个BlueField-4 DPU,通过NVLink 6交换机协调工作,再利用Spectrum-X技术将平台扩展到机架之e41g.cn/nuy|e41g.cn/lcd|e41g.cn/qov|e41g.cn/ta6|e41g.cn/8av|e41g.cn/veh|e41g.cn/kc6|e41g.cn/dfy|e41g.cn/ldm|e41g.cn/ca6外,将八套Vera Rubin NVL72整合成NVIDIA DGX SuperPOD,NVFP4推理和训练性能分别达到了3.6/2.5 EFLOPS。

HGX Rubin NVL8系统是专门针对x86架构打造的生成式AI平台,通过NVLink技术连接8个Rubin GPU,能够高效加速AI训练、推理及高性能计算(HPC)等多元化工作负载,也能灵活地整合至DGX SuperPOD。

『英伟达』表示,包括亚马逊AWS、谷歌、微软Azure和甲骨文在内的多家云服务供应商将于2026年率先部署基于Vera Rubin的实例。

『英伟达』创始人兼首席执行官黄仁勋在今年的CES 2026上,正式了最新的Rubin平台,确认“已经全面投产”,开启新的AI之旅。

新平台由六款全新『芯片』组成,包括Vera CPU、Rubin GPU、NVLink 6交换机、ConnectX-9 SuperNIC、BlueField-4 DPU和Spectrum-6以太网络交换机,通过极致的协同设计,打造成一台性能惊人的AI超级计算机,大幅缩短AI训练时间并降低推理Token生成成本。

Rubin平台以Vera Florence Cooper Rubin命名,这是一位具有开创精神的美国天文学家,她的发现改变了人类对宇宙的e41g.cn/dpu|e41g.cn/ans|e41g.cn/rzf|e41g.cn/zia|e41g.cn/dqx|e41g.cn/jfe|e41g.cn/1kj|e41g.cn/kps|e41g.cn/yk7|e41g.cn/hek理解。新平台包括NVIDIA Vera Rubin NVL72机架级扩展解决方案和NVIDIA HGX Rubin NVL8系统,引入了五项创新技术,分别为Vera CPU、新一代NVIDIA NVLink互连技术、第三代Transformer引擎、第三代NVIDIA机密计算、以及第二代RAS引擎。

Vera CPU拥有88个定制的Olympus核心,完全兼容Armv9.2,采用了“空间多线程(spatial multi-threading)”技术,可支持176个线程,每个核心拥有2M的L2缓存,另外还有162MB的统一L3缓存;最大支持1.5TB SOCAMM LPDDR5X内存,提供了1.2 TB/s的内存带宽;支持超高速NVLink-C2C互连技术,对应带宽可达到1.8 TB/s;支持PCIe 6.0和CXL 3.1标准。

Rubin GPU由两颗Die组成,集成了224个SM,第六代Tensor Core,HBM4提供了22 TB/s的带宽,每颗GPU拥有3.6 TB/s的NVLink带宽,NVFP4推理和训练性能分别达到了50/35 PFLOPS。与之前一样,『英伟达』还将两个Rubin GPU和一个Vera CPU组合在一起,带来了Vera Rubin Superchip,『芯片』之间通过NVLink-C2C互连技术连接。

NVLink 6交换机是Rubin平台的扩展架构,让Vera Rubin NVL72的Rubin GPU能够作为一个单一的、紧密耦合的加速器运行,在通信主导的工作负载下实现均匀的延迟和持续的带宽。每个Rubin GPU都通过NVLink 6得到了3.6 TB/s的双向带宽,相比上一代产品带宽翻倍。

ConnectX-9作为Spectrum-X以太网架构的智能端点,提供可预测的横向扩展性能,并强制执行流量隔离和安全操作。在Vera Rubin NVL72里,每个计算托架包含四块ConnectX-9 SuperNIC网卡,为每个Rubin GPU提供1.6 Tb/s的网络带宽。

BlueField-4 DPU负责控制、安全、数据传输和编排,作为AI工厂的软件定义控制平面运行,独立于主机CPU和GPU实现安全性、隔离性和运行确定性。其集成了Grace CPU,共有64核心,远高于BlueField-3 DPU的16个Cortex ‑A78核心,同时还配有128GB LPDDR5X内存以及ConnectX-9,可提供高达800 Gb/s的超低延迟以太网或InfiniBand连接。

Spectrum-6以太网络交换机基于共封装光器件的新一代Spectrum-X技术,为Rubin平台引入了以太网光子学,可以更好地支持AI工厂的横向扩展和横向扩展部署。其针对AI工作负载进行了优化设计,具有高度同步性、突发性和非对称性。通过使用200G PAM4 SerDes,将每个交换『芯片』的带宽提升至102.4 Tb/s。

Vera Rubin NVL72基于第三代NVIDIA MGX机架设计,采用了模块化配置,支持热插拔。其拥有72个Rubin GPU、36个Vera CPU、以及18个BlueField-4 DPU,通过NVLink 6交换机协调工作,再利用Spectrum-X技术将平台扩展到机架之外,将八套Vera Rubin NVL72整合成NVIDIA DGX SuperPOD,NVFP4推理和训练性能分别达到了3.6/2.5 EFLOPS。

HGX Rubin NVL8系统是专门针对x86架构打造的生成式AI平台,通过NVLink技术连接8个Rubin GPU,能够高效加速AI训练、推理及高性能计算(HPC)等多元化工作负载,也能灵活地整合至DGX SuperPOD。

『英伟达』表示,包括亚马逊AWS、谷歌、微软Azure和甲骨文在内的多家云服务供应商将于2026年率先部署基于Vera Rubin的实例。

『英伟达』创始人兼首席执行官黄仁勋在今年的CES 2026上,正式了最新的Rubin平台,确认“已经全面投产”,开启新的AI之旅。

新平台由六款全新『芯片』组成,包括Vera CPU、Rubin GPU、NVLink 6交换机、ConnectX-9 SuperNIC、BlueField-4 DPU和Spectrum-6以太网络交换机,通过极致的协同设计,打造成一台性能惊人的AI超级计算机,大幅缩短AI训练时间并降低推理Token生成成本。

Rubin平台以Vera Florence Cooper Rubin命名,这是一位具有开创精神的美国天文学家,她的发现改变了人类对宇宙的理解。新平台包括NVIDIA Vera Rubin NVL72机架级扩展解决方案和NVIDIA HGX Rubin NVL8系统,引入了五项创新技术,分别为Vera CPU、新一代NVIDIA NVLink互连技术、第三代Transformer引擎、第三代NVIDIA机密计算、以及第二代RAS引擎。

Vera CPU拥有88个定制的Olympus核心,完全兼容Armv9.2,采用了“空间多线程(spatial multi-threading)”技术,可支持176个线程,每个核心拥有2M的L2缓存,另外还有162MB的统一L3缓存;最大支持1.5TB SOCAMM LPDDR5X内存,提供了1.2 TB/s的内存带宽;支持超高速NVLink-C2C互连技术,对应带宽可达到1.8 TB/s;支持PCIe 6.0和CXL 3.1标准。

Rubin GPU由两颗Die组成,集成了224个SM,第六代Tensor Core,HBM4提供了22 TB/s的带宽,每颗GPU拥有3.6 TB/s的NVLink带宽,NVFP4推理和训练性能分别达到了50/35 PFLOPS。与之前一样,『英伟达』还将两个Rubin GPU和一个Vera CPU组合在一起,带来了Vera Rubin Superchip,『芯片』之间通过NVLink-C2C互连技术连接。

NVLink 6交换机是Rubin平台的扩展架构,让Vera Rubin NVL72的Rubin GPU能够作为一个单一的、紧密耦合的加速器运行,在通信主导的工作负载下实现均匀的延迟和持续的带宽。每个Rubin GPU都通过NVLink 6得到了3.6 TB/s的双向带宽,相比上一代产品带宽翻倍。

ConnectX-9作为Spectrum-X以太网架构的智能端点,提供可预测的横向扩展性能,并强制执行流量隔离和安全操作。在Vera Rubin NVL72里,每个计算托架包含四块ConnectX-9 SuperNIC网卡,为每个Rubin GPU提供1.6 Tb/s的网络带宽。

BlueField-4 DPU负责控制、安全、数据传输和编排,作为AI工厂的软件定义控制平面运行,独立于主机CPU和GPU实现安全性、隔离性和运行确定性。其集成了Grace CPU,共有64核心,远高于BlueField-3 DPU的16个Cortex ‑A78核心,同时还配有128GB LPDDR5X内存以及ConnectX-9,可提供高达800 Gb/s的超低延迟以太网或InfiniBand连接。

Spectrum-6以太网络交换机基于共封装光器件的新一代Spectrum-X技术,为Rubin平台引入了以太网光子学,可以更好地支持AI工厂的横向扩展和横向扩展部署。其针对AI工作负载进行了优化设计,具有高度同步性、突发性和非对称性。通过使用200G PAM4 SerDes,将每个交换『芯片』的带宽提升至102.4 Tb/s。

Vera Rubin NVL72基于第三代NVIDIA MGX机架设计,采用了模块化配置,支持热插拔。其拥有72个Rubin GPU、36个Vera CPU、以及18个BlueField-4 DPU,通过NVLink 6交换机协调工作,再利用Spectrum-X技术将平台扩展到机架之外,将八套Vera Rubin NVL72整合成NVIDIA DGX SuperPOD,NVFP4推理和训练性能分别达到了3.6/2.5 EFLOPS。

HGX Rubin NVL8系统是专门针对x86架构打造的生成式AI平台,通过NVLink技术连接8个Rubin GPU,能够高效加速AI训练、推理及高性能计算(HPC)等多元化工作负载,也能灵活地整合至DGX SuperPOD。

『英伟达』表示,包括亚马逊AWS、谷歌、微软Azure和甲骨文在内的多家云服务供应商将于2026年率先部署基于Vera Rubin的实例。

『英伟达』创始人兼首席执行官黄仁勋在今年的CES 2026上,正式了最新的Rubin平台,确认“已经全面投产”,开启新的AI之旅。

新平台由六款全新『芯片』组成,包括Vera CPU、Rubin GPU、NVLink 6交换机、ConnectX-9 SuperNIC、BlueField-4 DPU和Spectrum-6以太网络交换机,通过极致的协同设计,打造成一台性能惊人的AI超级计算机,大幅缩短AI训练时间并降低推理Token生成成本。

Rubin平台以Vera Florence Cooper Rubin命名,这是一位具有开创精神的美国天文学家,她的发现改变了人类对宇宙的理解。新平台包括NVIDIA Vera Rubin NVL72机架级扩展解决方案和NVIDIA HGX Rubin NVL8系统,引入了五项创新技术,分别为Vera CPU、新一代NVIDIA NVLink互连技术、第三代Transformer引擎、第三代NVIDIA机密计算、以及第二代RAS引擎。

Vera CPU拥有88个定制的Olympus核心,完全兼容Armv9.2,采用了“空间多线程(spatial multi-threading)”技术,可支持176个线程,每个核心拥有2M的L2缓存,另外还有162MB的统一L3缓存;最大支持1.5TB SOCAMM LPDDR5X内存,提供了1.2 TB/s的内存带宽;支持超高速NVLink-C2C互连技术,对应带宽可达到1.8 TB/s;支持PCIe 6.0和CXL 3.1标准。

Rubin GPU由两颗Die组成,集成了224个SM,第六代Tensor Core,HBM4提供了22 TB/s的带宽,每颗GPU拥有3.6 TB/s的NVLink带宽,NVFP4推理和训练性能分别达到了50/35 PFLOPS。与之前一样,『英伟达』还将两个Rubin GPU和一个Vera CPU组合在一起,带来了Vera Rubin Superchip,『芯片』之间通过NVLink-C2C互连技术连接。

NVLink 6交换机是Rubin平台的扩展架构,让Vera Rubin NVL72的Rubin GPU能够作为一个单一的、紧密耦合的加速器运行,在通信主导的工作负载下实现均匀的延迟和持续的带宽。每个Rubin GPU都通过NVLink 6得到了3.6 TB/s的双向带宽,相比上一代产品带宽翻倍。

ConnectX-9作为Spectrum-X以太网架构的智能端点,提供可预测的横向扩展性能,并强制执行流量隔离和安全操作。在Vera Rubin NVL72里,每个计算托架包含四块ConnectX-9 SuperNIC网卡,为每个Rubin GPU提供1.6 Tb/s的网络带宽。

BlueField-4 DPU负责控制、安全、数据传输和编排,作为AI工厂的软件定义控制平面运行,独立于主机CPU和GPU实现安全性、隔离性和运行确定性。其集成了Grace CPU,共有64核心,远高于BlueField-3 DPU的16个Cortex ‑A78核心,同时还配有128GB LPDDR5X内存以及ConnectX-9,可提供高达800 Gb/s的超低延迟以太网或InfiniBand连接。

Spectrum-6以太网络交换机基于共封装光器件的新一代Spectrum-X技术,为Rubin平台引入了以太网光子学,可以更好地支持AI工厂的横向扩展和横向扩展部署。其针对AI工作负载进行了优化设计,具有高度同步性、突发性和非对称性。通过使用200G PAM4 SerDes,将每个交换『芯片』的带宽提升至102.4 Tb/s。

Vera Rubin NVL72基于第三代NVIDIA MGX机架设计,采用了模块化配置,支持热插拔。其拥有72个Rubin GPU、36个Vera CPU、以及18个BlueField-4 DPU,通过NVLink 6交换机协调工作,再利用Spectrum-X技术将平台扩展到机架之外,将八套Vera Rubin NVL72整合成NVIDIA DGX SuperPOD,NVFP4推理和训练性能分别达到了3.6/2.5 EFLOPS。

HGX Rubin NVL8系统是专门针对x86架构打造的生成式AI平台,通过NVLink技术连接8个Rubin GPU,能够高效加速AI训练、推理及高性能计算(HPC)等多元化工作负载,也能灵活地整合至DGX SuperPOD。

『英伟达』表示,包括亚马逊AWS、谷歌、微软Azure和甲骨文在内的多家云服务供应商将于2026年率先部署基于Vera Rubin的实例。